En el ámbito de la inteligencia artificial, las organizaciones están rediseñando sus estrategias para adoptar un enfoque que integra múltiples modelos de lenguaje grandes (LLM) en el desarrollo de aplicaciones generativas. A pesar de que un solo modelo puede parecer apasionante en su capacidad, no siempre logra abordar de manera óptima los variados casos de uso ni los distintos requisitos de rendimiento que las empresas modernas demandan. Este novedoso enfoque estratégico permite a las organizaciones seleccionar el modelo más adecuado para cada tarea específica, adaptándose a diferentes dominios y optimizando elementos críticos como el costo, la latencia y la calidad. Esto resulta en aplicaciones más robustas, adaptativas y eficientes, mejor alineadas con las necesidades cambiantes de los usuarios y los objetivos empresariales.

Sin embargo, esta ambición técnica conlleva el reto de dirigir cada solicitud al modelo más competente para resolver la tarea demandada. Para ello, la lógica de enrutamiento debe interpretar de manera precisa el mensaje del usuario y canalizarlo hacia una de las tareas predefinidas, asigurando que cada petición sea tratada con el LLM más adecuado. De este modo, las aplicaciones pueden gestionar diversos tipos de tareas dentro de un mismo sistema, cada una con sus complejidades inherentes y sus dominios específicos.

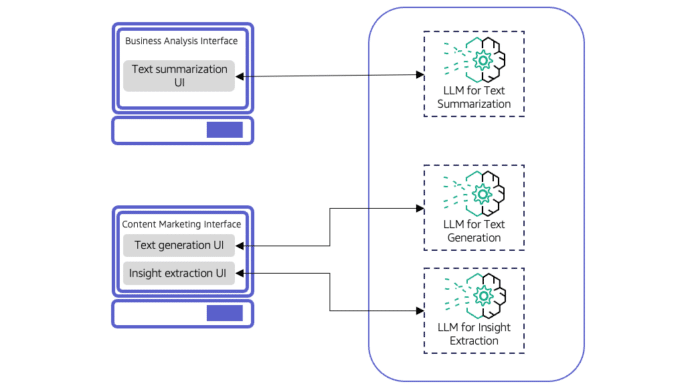

Numerosas aplicaciones podrían beneficiarse de este innovador enfoque de múltiples LLM. Por ejemplo, en la creación de contenido para marketing, se podrían requerir funcionalidades como generación de texto, resumen de información, análisis de sentimientos y extracción de datos, cada una dependiente de un modelo optimizado para su función. Conforme la complejidad de las aplicaciones crece, es crítico que puedan manejar distintos niveles de sofisticación atendiendo al usuario final. Un asistente de IA para resumir textos, por ejemplo, debe ser capaz de gestionar tanto consultas simples como complejas, adaptándose al tipo de documento con el que interactúa.

Para encaminar las solicitudes a diferentes LLM, existen dos principales aproximaciones: el enrutamiento estático y el dinámico. En el enrutamiento estático, se pueden implementar componentes de interfaz de usuario específicos para cada tarea, promoviendo así un diseño modular y sumamente flexible. Sin embargo, la adición de nuevas tareas puede exigir el desarrollo de nuevos componentes. El enrutamiento dinámico, utilizado comúnmente en asistentes virtuales y chatbots, intercepta las solicitudes mediante un único componente de UI, dirigiéndolas al LLM que mejor se adecua a la tarea encomendada.

Entre las técnicas dinámicas, el enrutamiento asistido por LLM utiliza un modelo clasificador para decidir el mejor camino de enrutamiento, pudiendo proporcionar clasificaciones más refinadas aunque a un costo mayor. La alternativa del enrutamiento semántico se basa en vectores numéricos para representar los mensajes de entrada y calculando su similitud con categorías predefinidas de tareas, siendo especialmente útil para aplicaciones que requieren adaptación constante a nuevas categorías.

Otra opción viable es el enfoque híbrido, que combina las técnicas estáticas y dinámicas para ofrecer un enrutamiento más sólido y adaptable a las distintas necesidades de usuarios. No obstante, implementar un sistema de enrutamiento robusto demanda un análisis meticuloso de costos, latencia y complejidad de mantenimiento, además de una evaluación permanente del rendimiento de los modelos utilizados.

Las organizaciones comienzan a explorar plataformas como Amazon Bedrock, que proporciona un servicio gestionado de LLM, facilitando el enrutamiento inteligente de solicitudes a diferentes modelos y permitiendo a los desarrolladores enfocarse en la creación de aplicaciones mientras se optimizan costos y calidad de las respuestas. Con una integración efectiva, se pueden disminuir los costos operativos hasta en un 30%.

El despliegue de múltiples LLM en aplicaciones de IA generativa amplía las capacidades organizativas y mejora la experiencia del usuario. Sin embargo, el éxito de esta implementación dependerá de un entendimiento profundo y manejo competente de sus complejidades y necesidades variadas.