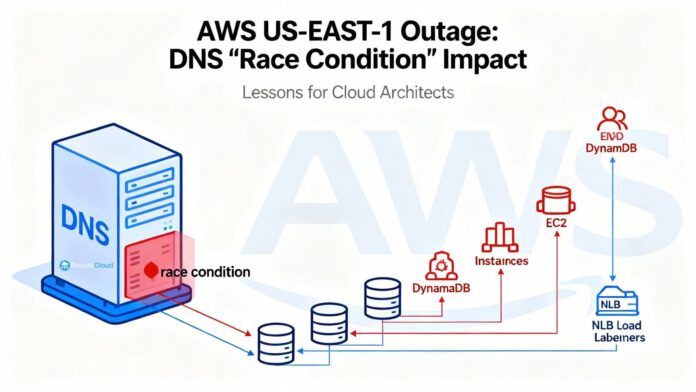

La reciente interrupción en la región N. Virginia (us-east-1) de AWS, que afectó a numerosos servicios el 19 y 20 de octubre, fue provocada por un fallo de carrera en la automatización que gestiona el DNS de Amazon DynamoDB. Este error desencadenó un impacto masivo, afectando a servicios críticos como IAM, EC2, Lambda y muchos otros, ya que la resolución del endpoint regional de DynamoDB falló.

AWS detuvo la automatización globalmente y tuvo que restaurar manualmente el estado correcto del DNS. Desde ese momento, servicios dependientes de DynamoDB y el correcto funcionamiento del Network Load Balancer (NLB) registraron disrupciones significativas debido a errores en la resolución y propagación de red.

El problema radicó en un fallo dentro del sistema que administra los planes DNS, que al operar con datos antiguos y nuevos de manera simultánea, dejó al endpoint sin direcciones, requeridendo intervención manual para corregir el estado en Amazon Route 53.

Adicionalmente, el lanzamiento de nuevas instancias EC2 fue otro desafío, debido al colapso en los sistemas que gestionan la infraestructura, causando una acumulación de colas y retrasos en la restauración del servicio. Servicios como Lambda y STS también sufrieron debido a la dependencia directa o indirecta de DynamoDB.

Las lecciones aprendidas y las medidas anunciadas remarcan la necesidad de diseñar arquitecturas que contemplen fallos de región, instando a las empresas a considerar configuraciones multi-región para mitigar el impacto ante futuras interrupciones. Destacan prácticas como diferenciar entre planos de datos y control, manejar adecuadamente los TTL en DNS, y prever escenarios de fallos mediante simulacros y runbooks detallados.

AWS afronta el desafío con medidas para fortalecer sus sistemas y prevenir situaciones similares en el futuro, lo que refuerza la importancia de una planificación resiliente por parte de las empresas que dependen de estas infraestructuras críticas.

Más información y referencias en Noticias Cloud.