La inteligencia artificial generativa está revolucionando las operaciones empresariales al permitir la creación de aplicaciones innovadoras que optimizan la experiencia tanto de clientes como de empleados. Desde el procesamiento inteligente de documentos hasta la personalización de contenidos de marketing, las empresas están adoptando estas tecnologías para mejorar sus servicios y eficiencia.

En grandes organizaciones, donde se manejan diversas unidades de negocio (LOBs), el uso de Amazon Web Services (AWS) bajo una estrategia de múltiples cuentas facilita la centralización de la gobernanza y la administración. En el corazón de esta estructura se encuentra el Centro de Excelencia en la Nube (CCoE), que administra los permisos de acceso y las políticas de gobernanza de cada cuenta, asegurando la cohesión entre los distintos equipos.

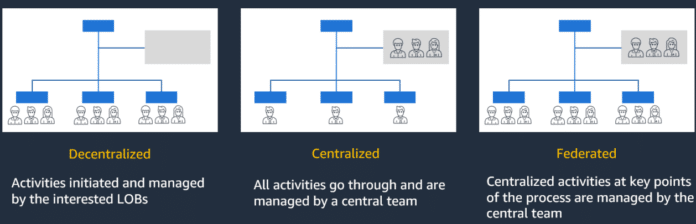

A medida que la IA generativa se vuelve esencial, las empresas desarrollan modelos operativos específicos para gestionarla. Estos modelos abordan aspectos clave como el diseño organizacional, los procesos básicos, tecnologías, roles requeridos, estructuras de gobernanza y modelos financieros. Las organizaciones deben elegir entre tres patrones principales según sus prioridades: descentralizado, centralizado y federado.

El modelo descentralizado otorga a las LOBs la capacidad de manejar su desarrollo de IA de manera independiente, ofreciendo mayor agilidad pero exigiendo al mismo tiempo alineación con los controles centrales para escalar efectivamente. En contraste, el modelo centralizado concentra todas las actividades de IA bajo un equipo especializado, proporcionando estandarización y control pero corriendo el riesgo de crear cuellos de botella.

El enfoque federado busca equilibrar la autonomía con el control central. Permite la experimentación y la innovación a nivel de LOB mientras un equipo central garantiza el cumplimiento de las políticas de seguridad y estándares de calidad. Este modelo aprovecha el conocimiento especializado de cada unidad de negocio y mantiene la gobernanza necesaria.

Para implementar estos modelos de manera efectiva, las empresas deben integrar componentes de arquitectura y servicios avanzados. Los modelos de lenguaje grande (LLMs) son vitales en este proceso, aunque su uso conlleva desafíos como la generación de respuestas incorrectas. Técnicas como la generación aumentada por recuperación (RAG) pueden mejorar la precisión al combinar recuperación de información con capacidades generativas.

El manejo de costos y la protección de la privacidad son también concernientes. Herramientas en AWS permiten monitorear el uso y los costos asociados, asegurando que la implementación de IA sea sostenible y eficiente.

Con un entorno empresarial que evoluciona rápidamente, las organizaciones deben ser ágiles en su adaptación a los avances tecnológicos. Los modelos operativos federados emergen como una solución eficaz para ofrecer innovación continua, mientras que un equipo centralizado garantiza el mantenimiento de los estándares de calidad y gobernanza. Amazon Bedrock proporciona una plataforma robusta para que las empresas desarrollen y escalen aplicaciones de inteligencia artificial generativa, allanando el camino hacia una transformación digital exitosa.