La creciente demanda de modelos de lenguaje específicos ha convertido su elección en un desafío crucial para las empresas. En el panorama actual, muchas organizaciones confían en evaluaciones superficiales, basándose en modelos populares y juicios personales, lo que puede resultar en decisiones equivocadas. Este enfoque a menudo no detecta errores sutiles ni comportamientos peligrosos.

Un método más exhaustivo sugiere evaluar los modelos con métricas tanto cualitativas como cuantitativas. Sin embargo, los sistemas de evaluación existentes no son lo suficientemente escalables para maximizar el uso de los modelos disponibles. Por lo tanto, un proceso de evaluación estructurado es fundamental para ayudar a las empresas a elegir el modelo que mejor se adapte a sus necesidades.

Las evaluaciones basadas en impresiones están limitadas por sesgos subjetivos. Los evaluadores podrían preferir estilos atractivos sin medir la precisión objetiva. Además, analizar solo unos pocos ejemplos interactivos no captura la complejidad del uso en el mundo real, omitiendo casos extremos que pueden revelar debilidades. La falta de un marco claro puede conducir a inconsistencias y no alinear la elección del modelo con objetivos comerciales.

Aunque benchmarks como MMLU y HellaSwag proporcionan evaluaciones estandarizadas, no se centran en dominios específicos. Esto implica que un modelo destacado en general puede fallar en contextos que requieren terminología específica, comprometiendo la calidad de las respuestas.

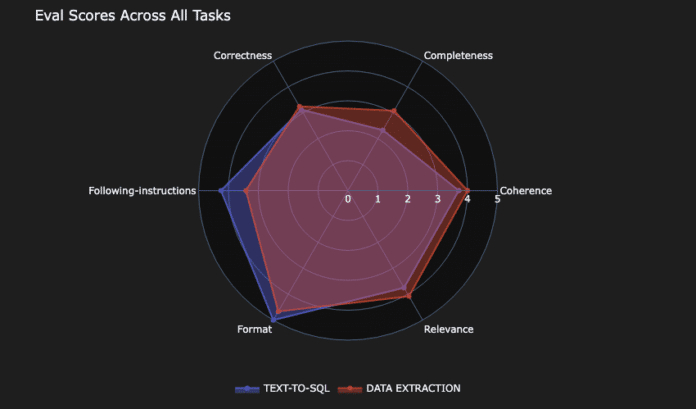

Para una evaluación eficaz, es esencial considerar varias dimensiones, incluyendo precisión, latencia y eficiencia de costos. Un marco de evaluación riguroso mejora la confianza en el modelo y permite análisis detallados. La combinación de métricas cuantitativas con juicios cualitativos permite evaluaciones más efectivas, abarcando corrección, completitud, relevancia y coherencia.

En este contexto, la iniciativa 360-Eval busca automatizar estos procesos, proporcionando una herramienta que evalúa el rendimiento de los modelos en profundidad. Este marco ayuda a organizaciones como AnyCompany a evaluar modelos de forma integral, enfatizando precisión, costo y eficiencia.

Como ejemplo, AnyCompany desarrolla una solución SaaS para mejorar la arquitectura de bases de datos. La herramienta recibe requisitos en lenguaje natural y genera modelos de datos para PostgreSQL. La empresa evalúa diversos modelos, priorizando respuestas rápidas y rentables sin perder calidad.

La elección final se basa en criterios de rendimiento, costo y precisión, permitiendo a las organizaciones adaptarse rápidamente a las necesidades del mercado. Con el avance rápido de la inteligencia artificial, contar con un sólido marco de evaluación se vuelve esencial para seleccionar el modelo ideal para cada caso específico.