La competencia por innovar en el mundo de la inteligencia artificial continúa intensificándose. La startup d-Matrix ha presentado un avance que promete revolucionar la eficiencia en la inferencia de modelos de IA. Su nueva tecnología, denominada 3D Digital In-Memory Compute (3DIMC), fue diseñada para acelerar y optimizar las tareas de inferencia, logrando ser, según la compañía, hasta diez veces más rápida y eficiente que la actual memoria de gran ancho de banda, conocida como HBM.

HBM ha sido la columna vertebral de las operaciones de entrenamiento en IA debido a su diseño de módulos apilados que permiten un ancho de banda considerable. A pesar de su eficacia, la startup afirma que las necesidades de la inferencia son diferentes y que la HBM se ve superada por sus limitaciones en costos y consumo energético.

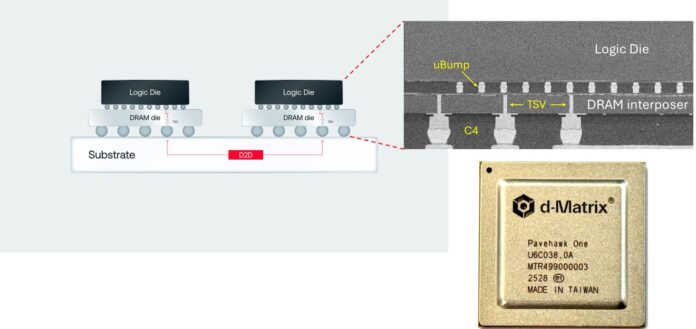

d-Matrix, bajo la dirección de su fundador y CEO, Sid Sheth, ha señalado que el problema reside en que la inferencia está «estrangulada por la memoria» más que por el poder de cálculo. Para solucionar esto, han desarrollado Pavehawk, un chip que combina memorias LPDDR5 con chiplets DIMC apilados en 3D, permitiendo realizar operaciones dentro de la memoria misma y así reducir significativamente la latencia y aumentar la eficiencia energética en un 90% comparado con HBM.

El impacto de esta innovación podría ser significativo, especialmente en un mercado donde los precios de HBM, controlado mayoritariamente por SK hynix, Samsung y Micron, están en constante aumento. De hecho, se anticipa un crecimiento del 30% anual en el mercado de HBM hasta 2030, incrementando la presión sobre los centros de datos que dependen de estas memorias.

A pesar de sus ventajas potenciales, algunos expertos advierten sobre los riesgos de una especialización excesiva. La preocupación radica en que el enfoque estrecho podría no adaptarse al ritmo acelerado y cambiante de la tecnología, especialmente en un contexto donde la sobreinversión ya es un tema recurrente.

La estrategia de d-Matrix se alinea con una tendencia de crear hardware específico para las distintas fases de la IA. La próxima decisión estratégica recae en los hyperscalers, como Google, Microsoft y Amazon, quienes deberán evaluar si vale la pena integrar este tipo de tecnología.

Por ahora, d-Matrix, con su chip Pavehawk aún en fase de pruebas, proyecta que su desarrollo futuro, Raptor, será el que realmente compita con la HBM en el mercado, transformando potencialmente cómo se realiza la inferencia en IA.

Más información y referencias en Noticias Cloud.