Samsung Electronics ha lanzado TRUEBench, una innovadora herramienta de evaluación diseñada por Samsung Research para medir la productividad de la inteligencia artificial en entornos laborales. Este estándar ofrece un completo conjunto de métricas para evaluar el rendimiento de los modelos de lenguaje de gran tamaño (LLMs) en aplicaciones de productividad del mundo real, incluyendo diversos escenarios de diálogo y condiciones multilingües.

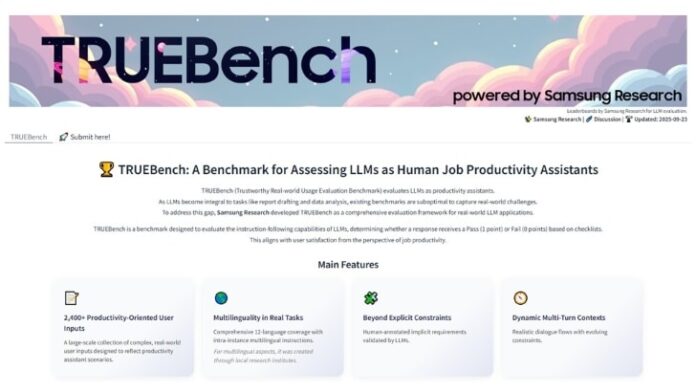

TRUEBench responde a la creciente necesidad de medir la efectividad de los LLMs en tareas empresariales comunes, como generación de contenido, análisis de datos, resumen y traducción. Con 10 categorías y 46 subcategorías, este benchmark incluye 2,485 conjuntos de pruebas en 12 idiomas, permitiendo escenarios interlingüísticos. Esto lo distingue de otros estándares que suelen estar limitados a estructuras de pregunta-respuesta simples y a un solo idioma.

Paul (Kyungwhoon) Cheun, CTO de la División DX de Samsung Electronics, subrayó la importancia de la experiencia práctica en IA de la empresa, afirmando que TRUEBench podría establecer un nuevo estándar de evaluación y reforzar el liderazgo tecnológico de Samsung en este campo.

El enfoque de evaluación de TRUEBench va más allá de medir solo la precisión de las respuestas, considerando que las instrucciones de los usuarios no siempre reflejan explícitamente sus intenciones. El sistema aborda estas condiciones implícitas a través de un proceso colaborativo entre humanos y IA, asegurando la precisión de los criterios de evaluación, evitando el sesgo subjetivo y garantizando consistencia.

Asimismo, los datos y clasificaciones de TRUEBench están disponibles en la plataforma de código abierto Hugging Face, donde los usuarios pueden comparar hasta cinco modelos diferentes. Esta transparencia en el rendimiento se complementa con detalles sobre la longitud promedio de las respuestas, proporcionando una visión integral de la eficiencia y efectividad de los modelos de IA en el mercado actual.