En el mundo del aprendizaje automático, la eficiencia y la precisión se han convertido en dos de los pilares más importantes para el éxito de cualquier proyecto. Amazon SageMaker Pipelines ha emergido como una herramienta indispensable para los científicos de datos y desarrolladores que buscan simplificar y optimizar sus flujos de trabajo de machine learning. Esta plataforma no solo facilita la automatización de tareas complejas, sino que también empodera a los equipos para enfocarse en la innovación y la mejora continua de modelos.

Equipado con un SDK de Python fácil de usar, SageMaker Pipelines ofrece la capacidad de orquestar flujos de trabajo intrincados, visualizándolos de manera efectiva a través de SageMaker Studio. Este enfoque permite a los usuarios aumentar la eficiencia en la preparación de datos, ingeniería de características y en la automatización del entrenamiento y despliegue de modelos. La integración con Amazon SageMaker Automatic Model Tuning añade una capa adicional de optimización, permitiendo la búsqueda automática de los mejores hiperparámetros según las métricas especificadas por los usuarios.

El interés por los modelos de conjuntos ha ido en aumento, ya que permiten lograr predicciones más precisas combinando los resultados de múltiples modelos. Con SageMaker Pipelines, los desarrolladores pueden implementar un proceso de machine learning integral para estos modelos, asegurando precisión, eficiencia y reproducibilidad.

Un caso reciente ilustra el uso eficaz de este enfoque mediante un modelo de conjunto desarrollado para identificar casos de uso en oportunidades generadas en Salesforce por representantes de ventas. Estos modelos, que se benefician del aprendizaje no supervisado, permiten clasificar automáticamente los casos según la industria y los ingresos potenciales, optimizando así las analíticas y mejorando los modelos de recomendación de ventas. Empleando técnicas avanzadas como Latent Semantic Analysis (LSA), Latent Dirichlet Allocation (LDA) y, finalmente, BERTopic, el modelo logró superar desafíos comunes, estableciendo nuevos estándares en eficiencia.

El planteamiento se concreta en la utilización de tres modelos secuenciales de BERTopic en un método jerárquico para la agrupación final, apoyado por técnicas como UMAP para reducción de dimensiones y BIRCH para clustering, garantizando así resultados precisos. No obstante, la implementación de esta estrategia enfrenta retos significativos, desde el preprocesamiento de datos hasta la necesidad de un entorno computacional escalable y adaptable para manejar grandes volúmenes de información.

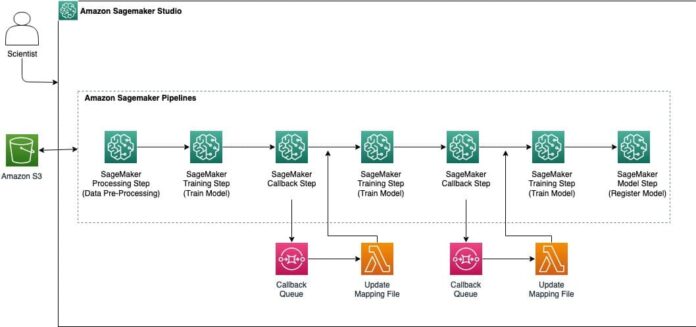

Desde una perspectiva arquitectónica, SageMaker Studio actúa como el núcleo de esta solución, ofreciendo un entorno colaborativo para la construcción, entrenamiento y despliegue de modelos a gran escala. La coordinación de los flujos de trabajo automatizados se logra a través de pasos de procesamiento, entrenamiento y modelado bien estructurados.

Este caso de uso ilustra el potencial de Amazon SageMaker Pipelines no solo para impulsar la innovación, sino también para superar las barreras de la automatización y escalabilidad en proyectos de inteligencia artificial y machine learning.