Los chatbots de inteligencia artificial y los asistentes virtuales han ganado una enorme popularidad en los últimos años, principalmente debido a los avances en modelos de lenguaje de gran capacidad (LLMs por sus siglas en inglés). Estos modelos, entrenados con vastos conjuntos de datos y con componentes de memoria en sus diseños, son capaces de comprender y contextualizar texto de manera eficiente.

En el ámbito empresarial, los asistentes chatbot se utilizan principalmente para mejorar la experiencia del cliente, aumentar la productividad y creatividad de los empleados, y optimizar procesos internos. Su aplicación se extiende desde el soporte al cliente y la resolución de problemas, hasta la búsqueda de conocimiento tanto interna como externamente.

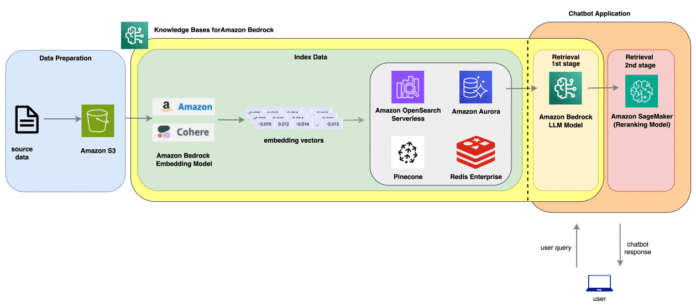

Sin embargo, a pesar de estas avanzadas capacidades, uno de los desafíos más significativos sigue siendo la generación de respuestas precisas y de alta calidad. Para afrontar este reto, se ha desarrollado la técnica de Generación de Recuperación Aumentada (RAG). RAG optimiza la salida de los modelos LLM refiriéndose a una base de conocimiento autorizada externa a sus datos de entrenamiento antes de generar una respuesta. La técnica de reordenamiento dentro de RAG busca mejorar la relevancia de la búsqueda reorganizando los resultados de un recuperador inicial utilizando un modelo distinto.

RAG combina la recuperación de información de una base de conocimiento con modelos generativos para producir texto. Inicialmente, recupera respuestas relevantes de una base de datos, utilizando esas respuestas como contexto para el modelo generativo que luego produce la salida final. Este enfoque tiene varias ventajas, como proporcionar respuestas más coherentes y relevantes y mejorar el flujo de conversación. RAG también escala mejor con el incremento de datos y no requiere ajustes del modelo cuando se añade nueva información a la base de conocimiento.

Para encontrar una respuesta, RAG emplea la búsqueda vectorial a través de documentos. La búsqueda vectorial es rápida y escalable; convierte los textos en embeddings, que son representaciones comprimidas de los documentos en un arreglo de valores numéricos. Estos embeddings se almacenan en una base de datos, y la búsqueda consulta esta base de datos vectorial para encontrar similitudes en los vectores asociados.

Una técnica adicional que potencia la precisión de las respuestas es la reordenación, que selecciona la mejor opción entre varias respuestas candidatas. Un ejemplo práctico de esta técnica involucra la implementación de un flujo de trabajo RAG de extremo a extremo con «El Gran Gatsby» de F. Scott Fitzgerald, usando Bases de Conocimiento para Amazon Bedrock y una colección de búsqueda vectorial sin servidor de Amazon OpenSearch.

Preguntas generadas desde el documento con un LLM de Amazon Bedrock y una base de conocimientos pueden luego ser evaluadas utilizando la API de recuperación estándar RAG y una RAG de dos etapas, que incluye reordenación. La comparativa de estos dos métodos resulta clave.

Para medir la efectividad del RAG, se utiliza el marco RAGAS, que evalúa dimensiones como la relevancia de la respuesta, la similitud de la respuesta y la relevancia del contexto. En pruebas con «El Gran Gatsby», los resultados de un enfoque RAG estándar pueden verse mejorados con una reordenación adicional utilizando modelos avanzados, como bge-reranker-large disponible en Hugging Face Hub.

Las conclusiones de estos análisis han demostrado que usar un modelo de reordenación incrementa la relevancia del contexto, la precisión de la respuesta y la similitud, aunque supone un mayor tiempo de latencia. En resumen, la integración de modelos de reordenación con Bases de Conocimiento para Amazon Bedrock proporciona un mejor rendimiento en términos de precisión y relevancia de las respuestas generadas.