La inteligencia artificial generativa (GenAI) está revolucionando múltiples sectores al agilizar procesos e impulsar la innovación. Aunque son comunes las interacciones textuales a través de chat, en la práctica, el éxito de GenAI muchas veces depende de integrar datos estructurados en APIs, bases de datos y cargas de trabajo centradas en datos. Este tipo de integración mejora la inteligencia conversacional, ofreciendo respuestas más confiables y prácticas. No obstante, la imprevisibilidad de los modelos de lenguaje de gran tamaño (LLMs) presenta un desafío, complicando la generación consistente de salidas estructuradas como JSON.

El problema radica en que los LLMs se entrenan predominantemente con texto no estructurado, como artículos y páginas web, y no tanto con formatos estructurados. Esto afecta la precisión al generar salidas JSON, esenciales para una integración sin contratiempos en APIs y bases de datos. La capacidad de estos modelos para reconocer tipos de datos y manejar jerarquías complejas varía, lo cual es un factor crucial al seleccionar un modelo.

Para enfrentar estos desafíos, Amazon Bedrock, un servicio que ofrece acceso seguro a avanzados modelos de IA, introduce dos soluciones: la ingeniería de prompts y el uso de herramientas con la API Bedrock Converse.

La ingeniería de prompts es un enfoque directo donde se crean salidas estructuradas a través de prompts bien definidos. Por otro lado, el uso de herramientas con la API Bedrock Converse proporciona un control más avanzado, garantizando consistencia e integración de esquemas JSON.

Un ejemplo práctico de análisis de reseñas de clientes demuestra cómo Bedrock genera salidas estructuradas, como puntuaciones de sentimientos, utilizando código Python simplificado. El proceso incluye configurar el cliente Bedrock, diseñar un esquema JSON, formular un prompt claro, añadir datos de reseñas e invocar Bedrock para obtener la respuesta.

La API Converse permite conversaciones de múltiples turnos con modelos de IA generativa, integrando esquemas JSON directamente en las definiciones de herramientas, lo que asegura que las salidas se ajusten a los formatos predefinidos.

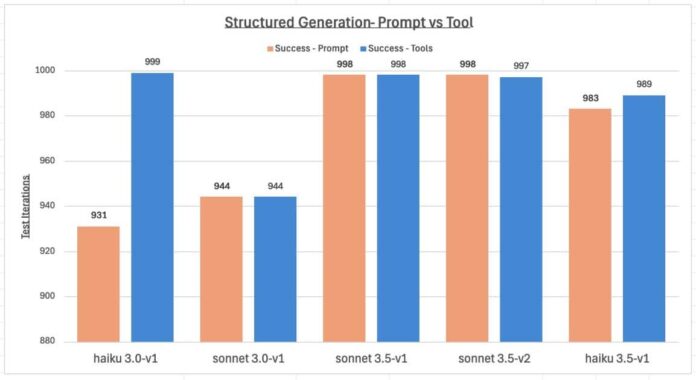

Pruebas en los modelos Claude de Anthropic mostraron que más del 93% de éxito se logró en la generación de respuestas estructuradas, siendo el método de uso de herramientas más eficiente que la ingeniería de prompts. Estos resultados, obtenidos bajo condiciones complejas, sugieren que futuras actualizaciones de los modelos seguirán mejorando su eficacia.

En resumen, Amazon Bedrock ofrece dos métodos para generar respuestas estructuradas: la ingeniería de prompts y el uso de herramientas. Ambos presentan ventajas y aplicaciones distintas según las necesidades específicas. La integración de datos estructurados es clave para explotar al máximo la inteligencia artificial generativa en escenarios del mundo real, como APIs y cargas de trabajo basadas en datos.