En el dinámico campo de la inteligencia artificial, los modelos de lenguaje a gran escala (LLMs) han emergido como herramientas cruciales, capaces de comprender y generar lenguaje natural con una notable agilidad. Este avance continuo busca constantemente superar las barreras en términos de tamaño, rendimiento y eficiencia de estos modelos, y, en este contexto, Amazon SageMaker ha marcado un nuevo hito en 2023.

La integración de instancias P5, que se apoyan en la tecnología de las más recientes GPUs NVIDIA H100 Tensor Core, ha sido un paso significativo. Estas instancias están meticulosamente diseñadas para entrenar modelos altamente complejos en entornos distribuidos, aprovechando tecnologías de red de alto ancho de banda como EFA. Esto ha permitido entrenar modelos en paralelo en múltiples nodos, optimizando la velocidad y eficiencia de los procesos de entrenamiento.

Un avance particularmente relevante ha sido la introducción de la precisión FP8 en el entrenamiento de LLMs. Este tipo de dato, apoyado por las capacidades avanzadas de las GPUs NVIDIA H100, ha demostrado ser un cambio de juego. FP8 permite una utilización más eficiente de la memoria y ofrece una computación más rápida, evitando comprometer la calidad del modelo. Esta precisión facilita la reducción del tamaño de los datos y disminuye los requerimientos computacionales, permitiendo no solo entrenar modelos más grandes con los mismos recursos, sino también reducir el tiempo de entrenamiento sin sacrificar el rendimiento.

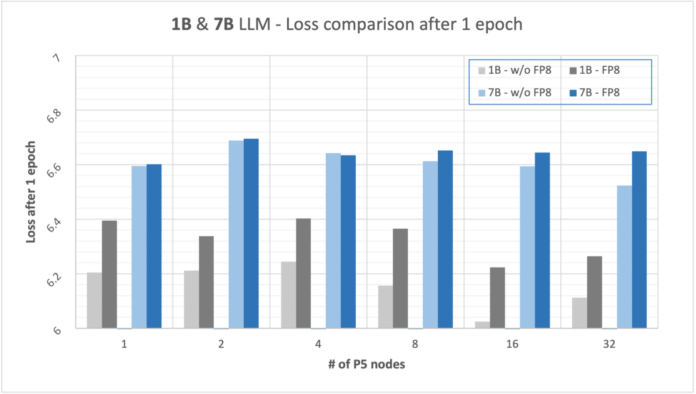

Los estudios realizados con modelos de 1B y 7B parámetros han arrojado resultados impresionantes. Los modelos entrenados utilizando FP8 mostraron un aumento en la velocidad de entrenamiento del 13% en modelos de 1B y del 18% en modelos de 7B. Aunque se observó una leve degradación en la pérdida del modelo tras un epoch, este efecto resultó ser marginal, con un incremento del 3% para modelos de 1B y 2% para modelos de 7B en comparación con entrenamientos sin FP8.

La adopción de FP8 junto con las instancias P5 no solo marca un avance tecnológico prometedor, sino que invita a más investigadores y organizaciones a implementar estas técnicas. Este desarrollo no solo acelera el entrenamiento de modelos a gran escala, sino que también extiende sus beneficios a otros campos como la visión por computadora y el aprendizaje por refuerzo. Estas mejoras permiten entrenar modelos más complejos en menos tiempo y con menos recursos, potenciando además el rendimiento en tareas de inferencia.

En suma, los avances en precisión FP8 combinados con las capacidades de las instancias P5 en SageMaker marcan un paso crucial hacia una mayor optimización y eficiencia en el entrenamiento de LLMs, proyectando un potencial robusto para futuros desarrollos en inteligencia artificial.