La creciente demanda de integrar inteligencia artificial generativa en los negocios ha impulsado el desarrollo de enfoques innovadores como el uso de modelos de lenguaje de gran tamaño preentrenados. Uno de los servicios líderes en este campo es Amazon Bedrock, una plataforma que gestiona modelos de vanguardia de diversas startups de inteligencia artificial y de Amazon, accesibles a través de una API. Esto permite a las empresas elegir el modelo que mejor se adapta a sus necesidades específicas.

Amazon Bedrock no solo proporciona acceso a estos modelos, sino que también permite su personalización. Esta capacidad es vital para tareas avanzadas que requieren formatos específicos. La personalización se logra mediante técnicas de ajuste fino, que implica el uso de datos cuidadosamente etiquetados para entrenar un modelo preexistente y mejorar su rendimiento en aplicaciones particulares. Sin embargo, la recopilación de dichos datos de alta calidad continúa siendo un desafío significativo.

En respuesta a esta dificultad, la generación de datos sintéticos ha surgido como una alternativa prometedora. Crear datos de entrenamiento sintéticos con un modelo de lenguaje más grande no solo acelera el tiempo de respuesta, sino que también disminuye la necesidad de recursos intensivos, marcando una gran diferencia en escenarios con datos limitados.

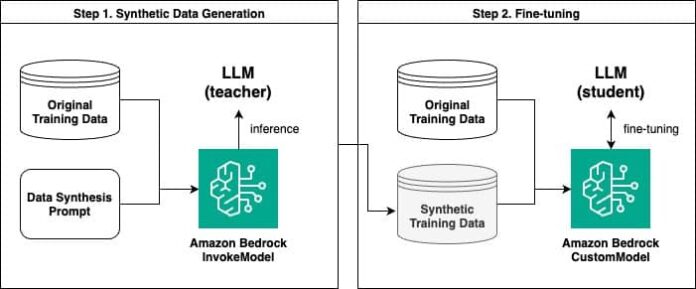

Amazon Bedrock facilita a los usuarios la generación de datos sintéticos y el ajuste de modelos de lenguaje sobre esta base. Un reciente estudio demostró cómo, en dos fases, se puede emplear esta plataforma para potenciar modelos de lenguaje. Primero, se generan datos sintéticos usando la API InvokeModel de Amazon Bedrock. Luego, estos datos se utilizan para afinar un modelo a medida.

El proceso de personalización comienza con la generación de pares de preguntas y respuestas sintéticas, donde un modelo de lenguaje más grande actúa como guía, ofreciendo información para entrenar un modelo más pequeño. Esta técnica, similar a la destilación del conocimiento en el aprendizaje profundo, ha mostrado ser eficaz para mejorar el rendimiento del modelo afectado.

Además, al comparar modelos afinados con datos originales frente a aquellos afinados con datos sintéticos, los resultados indicaron que los modelos afinados con datos sintéticos a menudo se desempeñaron mejor, aunque no siempre superaron a los entrenados con grandes cantidades de datos originales.

Se ha implementado también una nueva metodología de evaluación, el uso de un «modelo de lenguaje como juez», para medir la calidad de las respuestas de otros modelos. Los hallazgos evidenciaron que el modelo afinado con datos sintéticos destacó en su rendimiento.

En resumen, la utilización de Amazon Bedrock para crear y personalizar modelos mediante datos sintéticos ofrece una solución efectiva ante la escasez de datos en diversas aplicaciones. A medida que las empresas buscan formas más eficientes y económicas de personalizar sus modelos de lenguaje, estas estrategias podrían ser clave en su desarrollo y éxito.