En el dinámico campo de la inteligencia artificial, ha emergido un fenómeno conocido como «alucinaciones» en los modelos de lenguaje grande (LLM, por sus siglas en inglés). Este término describe la tendencia de estos sistemas a generar respuestas que, a pesar de parecer coherentes, resultan ser incorrectas o fabricadas. Este problema surge debido a las limitaciones inherentes del modelado de lenguaje, que favorece la fluidez y el contexto sobre la precisión factual.

La corrección de estas alucinaciones es crítica, especialmente en sectores como la salud, finanzas y derecho, donde la información errónea podría tener consecuencias graves. Las estrategias para mitigar este problema incluyen verificaciones exhaustivas de hechos, la integración de fuentes de conocimiento externas mediante enfoques como la Generación de Recuperación Aumentada (RAG, en inglés), la implementación de umbrales de confianza y la supervisión humana en procesos clave.

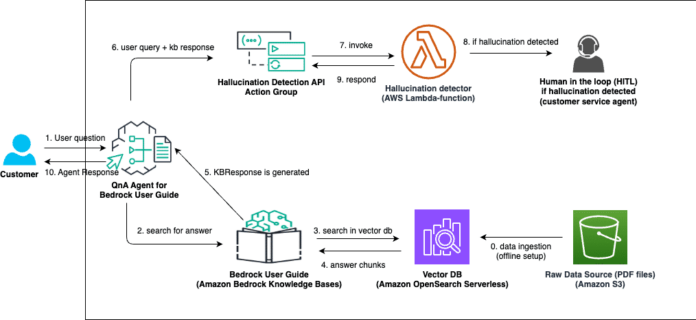

RAG ofrece una solución innovadora al integrar la capacidad de recuperar información externa relevante, que se utiliza para generar respuestas más precisas. Al incorporar datos verificados de fuentes confiables, RAG disminuye la posibilidad de que los modelos generen contenido erróneo o inventado, aumentando la precisión y fiabilidad de las respuestas.

Amazon ha introducido las Guardas de Bedrock, herramientas que permiten detectar alucinaciones a través de verificaciones contextuales. Estas soluciones pueden aplicarse utilizando APIs o flujos de prompts personalizados de Amazon Bedrock. No obstante, se enfrentan al desafío de ser estáticos, lo cual limita su adaptabilidad en un entorno cambiante.

Para abordar esta limitación, Amazon ha lanzado los Bedrock Agents, permitiendo la orquestación dinámica de flujos de trabajo. Esta herramienta ofrece a las organizaciones la posibilidad de implementar detección de alucinaciones de manera escalable y adaptable a sus necesidades, sin la necesidad de modificar completamente sus actuales flujos de trabajo.

Por ejemplo, si se detecta una alucinación, un flujo de trabajo configurado con agentes de Amazon puede redirigir la consulta a un agente de servicio al cliente, asegurando que el usuario reciba información precisa. Este sistema es comparable a la asistencia personalizada que un agente de servicio al cliente proporcionaría cuando un chatbot no logra responder adecuadamente a una consulta.

La combinación del enfoque RAG con flujos de trabajo gestionados por agentes ofrece un método versátil para identificar y mitigar alucinaciones. En última instancia, los Amazon Bedrock Agents permiten a las empresas desarrollar aplicaciones de inteligencia artificial generativa más precisas y personalizadas, optimizando procesos mediante la automatización AI, reduciendo costes y mejorando la productividad. Este avance marca un paso significativo hacia un uso más seguro y fiable de la inteligencia artificial, crucial para su aplicación en contextos donde la precisión informativa es esencial.