Los modelos de lenguaje grandes (LLMs, por sus siglas en inglés) están revolucionando las tareas de traducción automática (MT) al demostrar capacidades que compiten con los modelos tradicionales de traducción neuronal, como Amazon Translate. Estos modelos sobresalen en su habilidad para interpretar el contexto y captar matices culturales, ofreciendo traducciones que suenan más naturales y coherentes con el uso del lenguaje local.

Un ejemplo ilustrativo es la traducción de la pregunta «¿Te desempeñaste bien?» que varía según el contexto cultural. En un ámbito deportivo, como un torneo de fútbol, la traducción al francés debe reflejar esta especificidad. Para alcanzar una traducción precisa y fluida, es crucial que los algoritmos de inteligencia artificial comprendan tanto el contexto como las particularidades culturales.

Actualmente, numerosas empresas alrededor del mundo buscan aprovechar las capacidades de los LLMs para optimizar la calidad y localización de su contenido. El proceso conocido como Traducción Automática con Edición Posterior (MTPE) combina la automatización con la revisión humana, proporcionando ventajas económicas al reducir los costos de edición, acelerar tiempos de entrega y mejorar la experiencia del usuario final.

No obstante, los LLMs aún enfrentan desafíos, como inconsistencias en la calidad de traducción entre ciertos pares de idiomas, falta de integración de memoria de traducción (TM), y el riesgo de generar contenido erróneo o «alucinaciones».

Para avanzar en la implementación de LLMs en tareas de MT, se necesitan evaluaciones caso por caso. Sin embargo, el sector ya percibe un potencial para considerar estas herramientas como una opción viable dentro de sus operaciones.

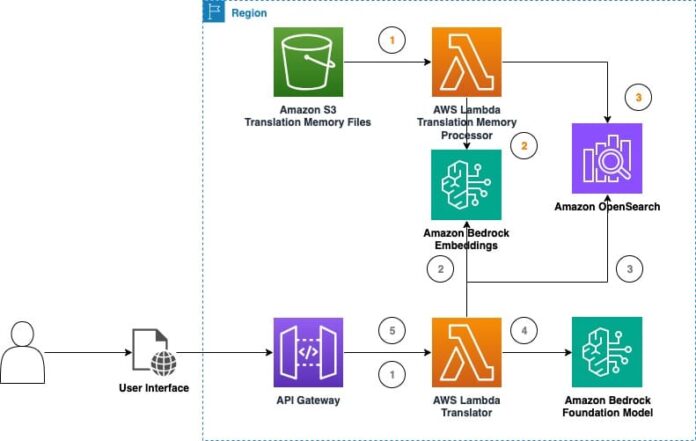

En este contexto, se ha introducido una solución que se basa en Amazon Bedrock para explorar el uso de LLMs en traducción automática en tiempo real. Esta solución integra técnicas de memoria de traducción y archivos TMX, lo cual es vital para la eficiencia y consistencia en proyectos de traducción asistida por computadora. La memoria de traducción almacena textos previamente traducidos, facilitando así el trabajo de los traductores y optimizando la gestión de contenido repetitivo.

La combinación de TMs con LLMs promete mejorar sustancialmente la calidad y eficiencia de la traducción automática. Los LLMs pueden adaptarse más eficazmente a la terminología y estilo del contenido utilizando traducciones de calidad almacenadas en TMs, lo cual puede disminuir el esfuerzo de edición post-traducción y, por ende, incrementar la productividad y reducir costos.

Estos avances operativos son complementados con estrategias de aprendizaje del contexto de LLMs y técnicas de ingeniería de prompt, que permiten a las compañías implementar modelos preexistentes sin dificultades operativas.

Un sofisticado «parque de pruebas de traducción LLM» permite a los usuarios practicar con las capacidades de estos modelos, comparando configuraciones de inferencia y evaluando el impacto de diferentes técnicas de optimización en la traducción.

En experimentos preliminares, los LLMs han demostrado adaptabilidad al contexto de las frases, lo que incrementó notablemente la calidad de las traducciones. Estos hallazgos sugieren que la combinación de LLMs con TMs será vital en futuros proyectos de localización y traducción.

El continuo desarrollo en los modelos de lenguaje grandes para traducción automática augura no solo mejoras considerables en la calidad de las traducciones, sino también un proceso de localización más efectivo y accesible para empresas de todas dimensiones.