En el competitivo mundo empresarial actual, demostrar el retorno de inversión en inteligencia artificial (IA) se ha convertido en una prioridad urgente. A pesar de ello, solo un 54% de los prototipos de aprendizaje automático (ML) alcanzan la producción, y aún menos casos de uso de IA generativa logran este destino. Este desafío no radica únicamente en llevar los proyectos a producción, sino en garantizar que estos modelos sean precisos y eficaces, lo cual requiere sistemas escalables y fiables con alta precisión y baja latencia.

La detección de fraudes es un ejemplo claro donde la baja latencia es indispensable, dado que se requiere una acción casi inmediata, como el tiempo que toma pasar una tarjeta de crédito. En 2023, Estados Unidos sufrió pérdidas por fraude que superaron los $10 mil millones, un aumento del 14% respecto al año anterior. Las expectativas indican que para 2027, las pérdidas globales en comercio electrónico podrían superar los $343 mil millones.

Para abordar este problema de manera eficaz, las empresas deben desarrollar y gestionar aplicaciones de IA precisas y fiables, lo que representa un desafío monumental. Inicialmente, los equipos de ML conectan manualmente componentes de infraestructura diversos, un proceso relativamente sencillo con datos por lotes, pero que se complica con el uso de fuentes de datos en tiempo real y de transmisión para ofrecer servicios inmediatos.

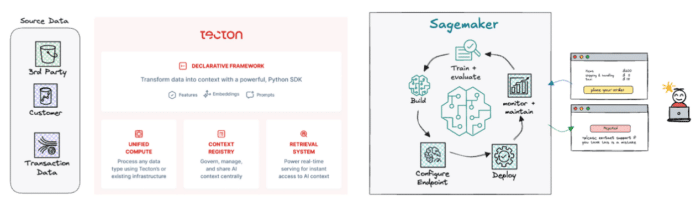

La complejidad aumenta al tener que construir y orquestar tuberías de datos, manejar las diversas necesidades de procesamiento de cada fuente de datos, gestionar la infraestructura de cómputo, y asegurar una infraestructura de servicio fiable para las inferencias. Aquí, Tecton entra en escena al ofrecer soluciones que simplifican este complejo entramado.

Tecton, en conjunto con Amazon SageMaker, reduce significativamente el esfuerzo de ingeniería necesario para aplicaciones de IA en producción en tiempo real. Este enfoque no solo acelera la obtención de valor, sino que permite que los equipos de ingeniería se concentren en desarrollar nuevas características en lugar de lidiar con la gestión de infraestructuras.

Esta solución ofrece un marco de trabajo declarativo que facilita la definición de transformaciones necesarias para los modelos, construyendo las tuberías para calcular, gestionar y servir estas características. Su integración con almacenes de datos en disco y en memoria, además del soporte de caché en memoria, permite ofrecer características a través de una API REST de baja latencia que satisface las demandas exigentes de casos de uso en tiempo real como la detección de fraudes.

Con esta infraestructura, es posible concretar un caso práctico de detección de fraudes, integrando API de terceros, extrayendo datos históricos y características del comportamiento del usuario, comparando actividades recientes y enviando la información a un modelo en SageMaker para evaluar la validez de cada transacción.

Tecton también abre nuevas oportunidades en el ámbito de la IA generativa, permitiendo integrar estas capacidades en aplicaciones existentes para proporcionar experiencias enriquecidas, como asistencia al cliente con información contextual relevante a través de modelos de lenguaje de gran escala (LLM).

En conclusión, Tecton y SageMaker capacitan a los equipos de IA para desplegar aplicaciones de alto rendimiento en tiempo real, eliminando la complejidad de la ingeniería de datos y facilitando un camino más directo hacia la generación de valor mediante la inteligencia artificial.