OpenAI ha dado un paso significativo en el avance de la inteligencia artificial con el lanzamiento de dos nuevos modelos de pesos abiertos. El primero, llamado gpt-oss-120b, cuenta con un impresionante volumen de 117 mil millones de parámetros, mientras que gpt-oss-20b ofrece 21 mil millones. Con un enfoque innovador basado en Mezcla de Expertos (MoE) y una ventana de contexto de 128K, estos modelos han alcanzado la cima en los benchmarks de Artificial Analysis, destacándose especialmente en tareas de razonamiento y gestión de flujos de trabajo.

A través de Amazon SageMaker AI, los usuarios tienen la posibilidad de personalizar y desplegar estos modelos con gran flexibilidad. Gracias a Amazon SageMaker Inference, es posible incorporar código propio de inferencia sin la complejidad de mantener clústeres, optimizando así procesos de implementación para empresas y desarrolladores.

Aunque los grandes modelos de lenguaje (LLMs) sobresalen en la generación y comprensión del lenguaje, su aplicación en escenarios del mundo real presenta desafíos significativos. La gestión de flujos de trabajo autónomos y la capacidad de integración de múltiples herramientas son áreas que requieren un enfoque especializado. Las arquitecturas basadas en múltiples agentes descomponen problemas complejos en componentes manejables, enfrentando el reto de coordinar y orquestar eficazmente sus interacciones.

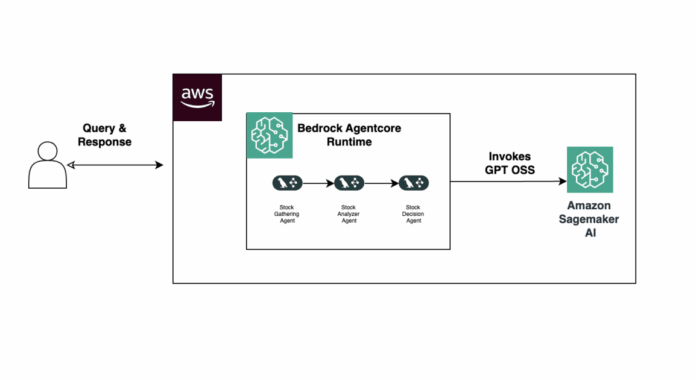

En una reciente publicación, se detalló el despliegue del modelo gpt-oss-20b utilizando los endpoints gestionados de SageMaker. Un ejemplo práctico demostró el uso de LangGraph, un marco basado en gráficos que gestiona el estado y coordina flujos de trabajo, para crear un asistente especializado en análisis de acciones. El siguiente paso implica desplegar estos agentes en Amazon Bedrock AgentCore, que ofrece una capa de orquestación unificada para manejar infraestructura de manera segura y a gran escala.

La solución propuesta incluye componentes clave: el modelo GPT OSS 20B usando vLLM en un endpoint de SageMaker, LangGraph para la orquestación de agentes, y Amazon Bedrock AgentCore para la gestión y despliegue seguros. Esta arquitectura permite a los usuarios enviar consultas que son procesadas por agentes especializados, optimizando el análisis y aumentando la productividad mediante la automatización de tareas rutinarias.

Además, se dispone de guías detalladas para configurar entornos, gestionar permisos y realizar despliegues de manera eficiente. Herramientas como vLLM y Amazon Elastic Container Registry juegan un papel crucial en facilitar el hospedaje continuo y eficiente.

La comunidad de desarrolladores está invitada a explorar y adaptar estos flujos de trabajo de agentes para una variedad de casos de uso, destacando el potente papel que los modelos de código abierto pueden jugar en la optimización y transformación de procesos empresariales.