La latencia y el costo son desafíos persistentes en el ámbito de la inteligencia artificial generativa, específicamente cuando se emplean modelos de lenguaje de gran tamaño (LLMs, por sus siglas en inglés). Estos modelos, al procesar el texto de forma secuencial y predecir un token a la vez, pueden introducir demoras considerables que afectan la experiencia del usuario. La creciente demanda de aplicaciones basadas en inteligencia artificial ha provocado, además, que el volumen de llamadas a estos modelos llegue a niveles que pueden sobrepasar los presupuestos, generando presiones financieras para las empresas.

En respuesta a estas problemáticas, una nueva estrategia de optimización ha emergido. Se trata de una innovadora caché de lectura intermedia sin servidor que explota patrones de datos repetidos. Esta solución permite a los desarrolladores almacenar y acceder a respuestas recurrentes, mejorando la eficiencia y los tiempos de respuesta de las aplicaciones. La propuesta utiliza Amazon OpenSearch Serverless conjuntamente con Amazon Bedrock, un servicio gestionado que brinda modelos base de alto rendimiento a través de una sola API, facilitando la construcción segura y privada de aplicaciones de inteligencia artificial generativa.

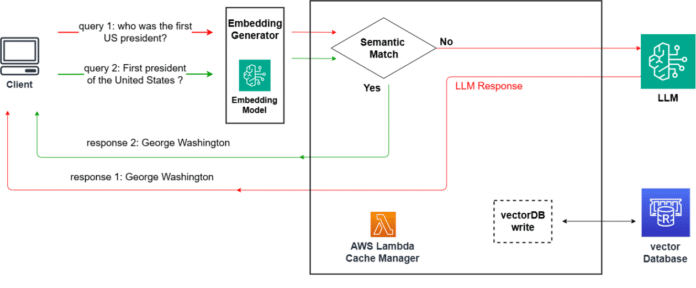

La caché actúa como un buffer que intercepta las solicitudes en lenguaje natural antes de ser procesadas por el modelo central. Almacena consultas similares semánticamente, permitiendo una rápida recuperación de información, reduciendo así la necesidad de recurrir al modelo de lenguaje para generar una nueva respuesta. Esta técnica es esencial para lograr un equilibrio entre la maximización de los aciertos en caché y la minimización de las colisiones.

Imaginemos un asistente de inteligencia artificial para una agencia de viajes. En este caso, podría ser beneficioso conservar un alto volumen de respuestas incluso si se producen algunas superposiciones. En cambio, un asistente destinado a consultas de agentes demandaría una asignación precisa por solicitud, minimizando así las posibles equivocaciones.

El sistema de caché almacena incrustaciones vectoriales numéricas de las consultas de texto, convirtiéndolas en vectores para su almacenamiento. Gracias a los modelos de incrustación gestionados por Amazon Bedrock, se pueden establecer bases de datos vectoriales con OpenSearch Serverless, asegurando un sistema de caché sólido y robusto.

La implementación de esta innovación no solo mejora los tiempos de respuesta de los sistemas, sino que también implica una reducción significativa de costos. A diferencia de los modelos de generación, los modelos de incrustación suelen ser más económicos, lo que resulta en una eficiencia de costos sustancial para diversos escenarios de uso.

Este avance no solo eleva la eficiencia de los sistemas LLM, sino que optimiza la experiencia del usuario. La capacidad de ajustar los umbrales de similitud permite alcanzar un equilibrio adecuado entre aciertos y colisiones de caché, optimizando así el funcionamiento de las herramientas de inteligencia artificial generativa.