En el dinámico mundo de la inteligencia artificial, la optimización de modelos de lenguaje base ha emergido como un área crucial para mejorar la precisión y especificidad de los resultados en diversos campos. Recientemente, ha cobrado notoriedad un experimento realizado con Amazon SageMaker Autopilot y el SDK AutoMLV2, que afinó un modelo Meta Llama2-7B, centrado en tareas de respuesta a preguntas en exámenes de ciencias que abarcan disciplinas como la física, química y biología.

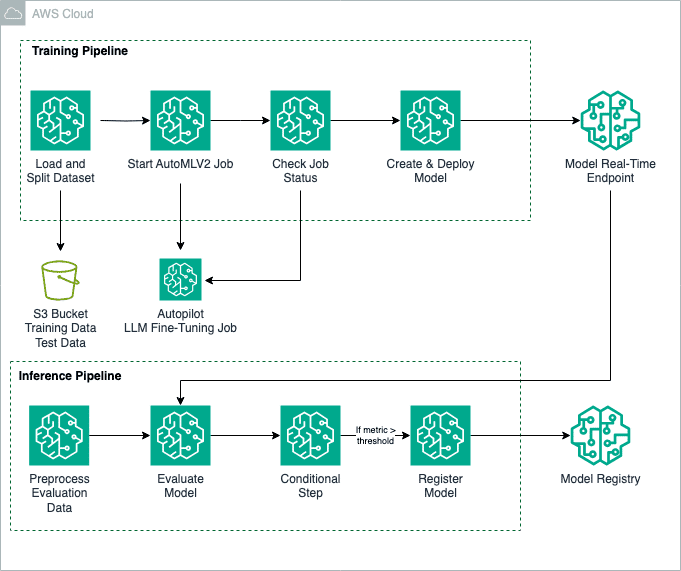

Este proceso innovador no se limita únicamente a responder preguntas, sino que también promete extensiones significativas en áreas como la generación de resúmenes y la creación de textos en sectores clave como la atención médica, educación y servicios financieros. AutoMLV2 se convierte en una herramienta poderosa, permitiendo la personalización de los modelos mediante la plataforma Amazon SageMaker JumpStart. Para automatizar las etapas del flujo de trabajo, se emplea Amazon SageMaker Pipelines, lo que facilita desde la preparación de datos hasta el despliegue del modelo.

La metodología se basa en el uso del conjunto de datos SciQ, un valioso repositorio que ofrece preguntas de examen relacionadas con las ciencias. Estos datos se organizan en archivos CSV con columnas de preguntas y respuestas, adaptándolos a las necesidades de SageMaker Autopilot para entrenar el modelo Llama2-7B.

Durante la configuración del afinamiento, son cruciales parámetros como el nombre del modelo base, la aceptación de contratos de licencia de usuario final (EULA), y la optimización a través de hiperparámetros que ajustan el aprendizaje del modelo, como el número de épocas y la tasa de aprendizaje. Esta personalización permite adaptar el entrenamiento del modelo a los requerimientos específicos de cada tarea.

El modelo afinado se despliega en un punto de inferencia en tiempo real, ofreciendo respuestas instantáneas y precisas. Su rendimiento es evaluado con la biblioteca fmeval, que proporciona un análisis detallado a través de métricas personalizadas, garantizando que el modelo opere adecuadamente en entornos reales. Esta rigurosa evaluación asegura que solo los modelos con alto rendimiento sean registrados y puestos en producción.

Este enfoque no solo incrementa la precisión del modelo en su tarea principal, sino que también simplifica el despliegue y evaluación, optimizando la implementación de modelos en plataformas de producción. Al asegurar un estricto control de calidad mediante la evaluación de métricas de rendimiento, se garantiza que los modelos entreguen inferencias precisas y relevantes en tiempo real.

Este flujo automatizado supone un avance significativo hacia la integración eficiente de modelos de lenguaje a gran escala, permitiendo una incorporación más fluida en sistemas que demandan un alto grado de precisión.