La inferencia emerge como la nueva frontera competitiva en inteligencia artificial, con modelos que han evolucionado más allá de ser simples generadores de texto o imágenes, transformándose en sistemas agénticos con la capacidad de razonar en múltiples pasos. En este contexto, NVIDIA ha dado un paso adelante con el lanzamiento de Rubin CPX, una GPU diseñada específicamente para acelerar las cargas de trabajo de contexto masivo, optimizando tanto el rendimiento como la eficiencia.

A medida que la inteligencia artificial se infiltra en diversas industrias, las demandas a las infraestructuras tecnológicas se intensifican. En el ámbito del desarrollo de software, por ejemplo, los asistentes de programación ahora deben ser capaces de analizar repositorios completos y establecer conexiones entre múltiples archivos y estructuras de proyectos. En la generación de vídeo, la narrativa coherente durante horas de metraje se vuelve crucial, lo que implica manejar contextos de más de un millón de tokens. Las infraestructuras tradicionales, limitadas a contextos cortos, ahora enfrentan desafíos significativos que incluyen limitaciones de memoria, ancho de banda de red y eficiencia energética.

Para abordar estas exigencias, NVIDIA introduce una arquitectura de «inferencias desagregadas», separando el proceso en dos fases: contexto y generación. Esta separación permite optimizar el uso de recursos, enfocando más potencia en la ingestión de datos iniciales y mayor ancho de banda en la generación sostenida de contenido. Sin embargo, este enfoque también añade complejidades, principalmente en la coordinación de cachés y en la gestión avanzada de memoria.

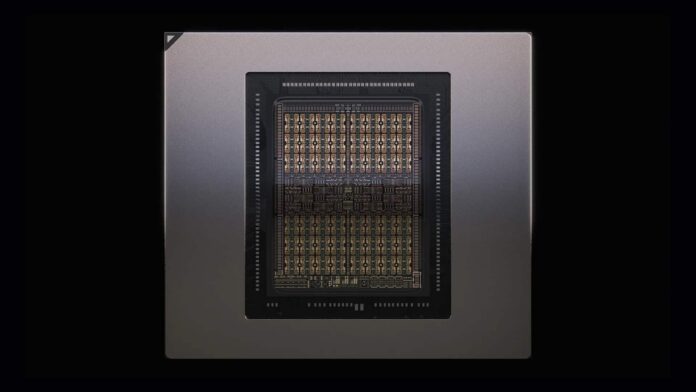

La GPU Rubin CPX, diseñada con la arquitectura Rubin, aborda estos retos con varias innovaciones significativas, como 30 petaFLOPs de cómputo en NVFP4, 128 GB de memoria GDDR7 de alta eficiencia y una aceleración de mecanismos de atención tres veces superior a generaciones anteriores. Estas características hacen de Rubin CPX una herramienta esencial para aplicaciones de alto valor, incluyendo el desarrollo de software avanzado, la generación de vídeo de alta definición y la investigación a gran escala.

Pero Rubin CPX no actúa en solitario. Forma parte de la plataforma NVIDIA Vera Rubin NVL144 CPX, que combina 144 GPUs Rubin CPX para la fase de contexto, junto con otros componentes que alcanzan una capacidad total de 8 exaFLOPs en NVFP4. Esta innovación establece nuevos estándares en la industria, superando en 7,5 veces la potencia de plataformas anteriores, asegurando baja latencia y escalabilidad a través de tecnologías avanzadas de interconexión.

Más allá del rendimiento técnico, NVIDIA destaca el impacto económico potencial de la Rubin CPX. Se proyecta un retorno de inversión de entre 30 y 50 veces, con la posibilidad de generar ingresos significativos por tokens procesados, un modelo atractivo para empresas que dependen de servicios de IA generativa.

Los casos de uso de Rubin CPX son variados y transformadores, con aplicaciones en desarrollo de software, generación de vídeo con calidad cinematográfica, análisis de grandes bases de datos en investigación y el avance de agentes autónomos. Todo ello bajo una integración completa en el stack de software de NVIDIA, asegurando su despliegue eficiente en diversas plataformas.

Se espera que Rubin CPX esté disponible para finales de 2026, alineándose con una creciente demanda por soluciones de inferencia de contexto largo. Con este lanzamiento, NVIDIA redefine las normas del juego, no solo con potencia, sino también proponiendo una forma más eficiente y económicamente viable de abordar los desafíos de la IA actual. Rubin CPX y la plataforma asociada sitúan a la inferencia masiva en el centro del debate tecnológico, marcando el inicio de una nueva era en la computación avanzada.

Más información y referencias en Noticias Cloud.