En el dinámico mundo de la inteligencia artificial, la aparición de modelos de lenguaje de gran tamaño (LLMs) ha revolucionado las capacidades tecnológicas actuales. Amazon Nova, presentado en 2024 y accesible a través de Amazon Bedrock, se posiciona como un líder en eficiencia y avanzada inteligencia, lo que ha llevado a una migración masiva de cargas de trabajo generativas hacia este modelo.

El principal desafío en esta transición radica en la optimización de los prompts, ya que los comandos utilizados en modelos previos pueden no ser efectivos en Amazon Nova. Para abordar este obstáculo, Amazon Bedrock ofrece una herramienta que ajusta automáticamente los prompts a las especificaciones de Nova, asegurando que el rendimiento post-migración sea óptimo o incluso mejor que con el modelo anterior.

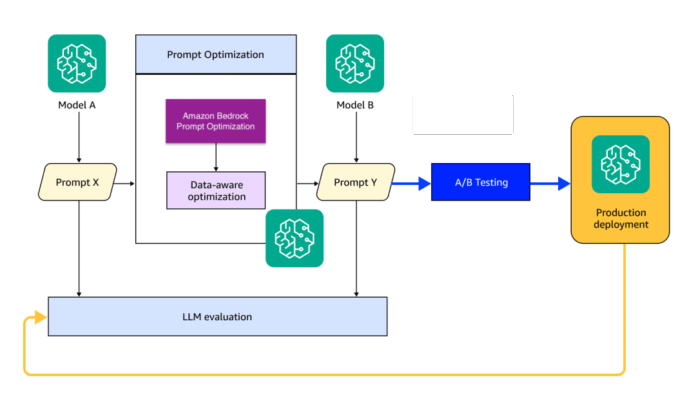

La arquitectura de migración desarrollada para Amazon Nova se basa en un proceso continuo que envuelve evaluación, generación de prompts y optimización de datos. Este enfoque incluye tanto la evaluación del rendimiento anterior como la optimización iterativa de los prompts usando conjuntos de datos específicos, implementándose con éxito en tareas variadas como el resumen de textos y la clasificación de múltiples niveles.

El proceso de migración se lleva a cabo en cuatro pasos esenciales: evaluar el modelo fuente, actualizar los prompts, optimizarlos conforme a la nueva estructura, y realizar pruebas exhaustivas para validar el rendimiento en producción. Este método ha resultado en mejoras notables, evidenciadas en la optimización del Amazon Nova Lite, que incrementó su precisión inicial del 77.75% a un 87.75% tras la aplicación de un optimizador.

Las experiencias adquiridas subrayan la importancia de contar con datos de alta calidad, métricas adecuadas y un enfoque iterativo para maximizar el rendimiento del modelo. Este método no solo es aplicable a Amazon Nova, sino también a otros procesos de migración de modelos, permitiendo a las organizaciones elevar eficazmente sus capacidades en la inteligencia artificial generativa.