En el competitivo mundo de la inteligencia artificial generativa, la eficiencia en el tiempo de respuesta se ha convertido en un elemento tan esencial como la inteligencia misma de los modelos. Esta importancia se ha evidenciado particularmente en sectores como el servicio al cliente, donde las respuestas rápidas a consultas urgentes pueden determinar el éxito o fracaso de una interacción. Para los desarrolladores que dependen de sugerencias de código inmediatas, cada milisegundo cuenta. A medida que las empresas implementan modelos de lenguaje de gran tamaño (LLMs) para llevar a cabo tareas críticas, surge un desafío persistente: el delicado equilibrio entre rapidez y calidad en los resultados esperados de estos complejos sistemas.

La latencia, que se refiere al retraso experimentado en la respuesta de una aplicación, es una variable crucial en la experiencia del usuario. Más allá de considerarse un inconveniente menor, en aplicaciones interactivas de IA, cualquier demora puede interrumpir el flujo de una conversación, reducir la participación y, en último término, obstaculizar la aceptación general de las soluciones basadas en inteligencia artificial. Este desafío se amplifica con el aumento de la complejidad de las aplicaciones modernas que utilizan LLMs, donde frecuentemente se requieren múltiples consultas para resolver una sola tarea, extendiendo el tiempo total de procesamiento de cada respuesta.

En el reciente evento re:Invent 2024, Amazon dio a conocer una nueva función en su plataforma Bedrock que optimiza la latencia de los modelos de fundación (FMs). Esta mejora está diseñada específicamente para el modelo Claude 3.5 Haiku de Anthropic y los modelos Llama 3.1 de Meta, ofreciendo tiempos de respuesta más rápidos que sus versiones tradicionales. Esta innovación promete ser un cambio significativo para empresas con cargas de trabajo donde la rapidez es primordial, proporcionando una solución técnica para mejorar la agilidad operativa sin sacrificar la precisión.

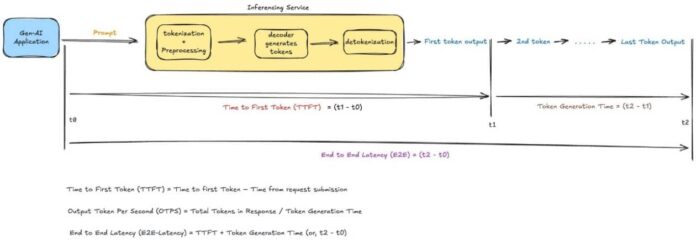

La optimización de la latencia es una estrategia multifacética que aborda aspectos cruciales como el tiempo hasta el primer token (TTFT), un indicador clave de cuán pronto una aplicación puede comenzar a responder después de recibir una consulta. Esta iniciativa refleja un esfuerzo continuo por parte de Amazon para perfeccionar la experiencia del usuario en aplicaciones impulsadas por LLMs, asegurando que la interacción con la inteligencia artificial sea lo más fluida y eficaz posible. En un entorno donde la rapidez es sinónimo de competitividad, estas mejoras no solo redefinen la relación entre usuarios y tecnología, sino que también establecen un nuevo estándar en el desarrollo y adopción de soluciones de inteligencia artificial.