En los últimos años, la inteligencia artificial generativa ha avanzado con rapidez, impulsada por inversiones en modelos de lenguaje sofisticados como Claude Opus 4, Sonnet 4 de Anthropic, Amazon Nova y Bedrock. Estos modelos han demostrado ser competentes en razonamiento, redacción y generación de respuestas. Sin embargo, se enfrentan al desafío de limitaciones de acceso a información pertinente, un problema que afecta a numerosas empresas.

Las organizaciones se encuentran frecuentemente atrapadas en silos de datos, donde valiosa información permanece detrás de APIs personalizadas. Este problema se complica con la complejidad de integración que requiere conectores específicos y código a medida para cada fuente de datos, además de los cuellos de botella en escalabilidad cuando se intenta conectar modelos a múltiples sistemas.

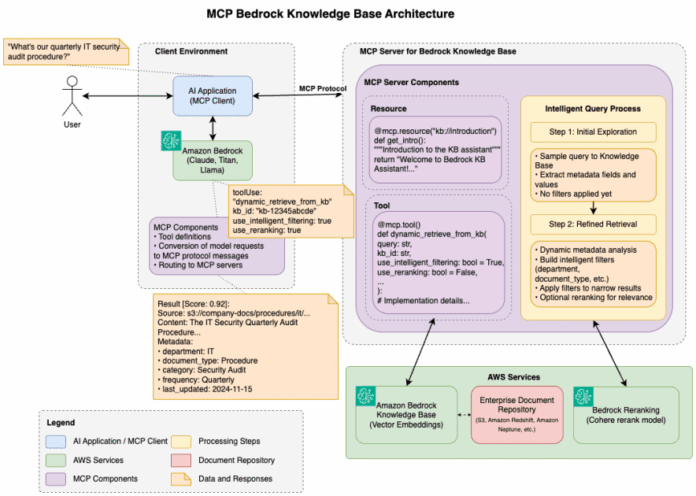

Para abordar estos desafíos, surge el Protocolo de Contexto de Modelo (MCP), desarrollado por Anthropic como un proyecto de código abierto. Este protocolo introduce un lenguaje universal para que los sistemas de IA se comuniquen de manera estandarizada con fuentes de datos externas. A través de una arquitectura cliente-servidor, las aplicaciones de IA funcionan como clientes que buscan acceso a datos, mientras que los servidores MCP facilitan este acceso de forma estandarizada.

El MCP simplifica el problema de integración M×N, donde M son las aplicaciones de IA y N las fuentes de datos, creando un marco eficaz para la conexión. Esto permite que las organizaciones desarrollen soluciones de IA escalables y eficientes, aprovechando la seguridad de AWS, incluyendo la gestión de identidad y acceso.

Especialmente relevante para los usuarios de AWS, el MCP mejora la integración de los modelos de lenguaje de Amazon Bedrock con servicios de datos de AWS. Esto facilita soluciones más composables y escalables, brindando una experiencia de usuario que combina IA con acceso a datos críticos, reduciendo la carga de desarrollo y costos de mantenimiento.

Mirando hacia el futuro, el MCP continúa evolucionando con mejoras constantes. Incluye un nuevo nivel de transporte HTTP que facilita despliegues a gran escala, asegurando una integración segura y eficaz entre aplicaciones de IA y la diversa gama de servicios de AWS.

En resumen, el Protocolo de Contexto de Modelo no solo avanza la interacción entre aplicaciones de IA y datos empresariales, sino que también ofrece un camino claro para que las organizaciones maximicen esta tecnología en el futuro.