En un mundo donde la inteligencia artificial generativa se está convirtiendo en una herramienta cotidiana para desarrolladores y usuarios avanzados, la capacidad de ejecutar modelos de lenguaje de forma local ha evolucionado de ser una opción experimental a convertirse en una alternativa robusta y eficaz. En este contexto, LM Studio se destaca como un entorno versátil y accesible para ejecutar modelos de IA sin depender de la nube.

Con su versión 0.3.15, LM Studio se integra de manera nativa con CUDA 12.8, el más reciente entorno de ejecución de NVIDIA, optimizando el rendimiento de las GPUs RTX. Esto promete tiempos de inferencia más rápidos, un uso de recursos más eficiente y una experiencia de inteligencia artificial generativa optimizada directamente en PCs personales.

La ejecución local de modelos de lenguaje ofrece varios beneficios clave en comparación con las soluciones basadas en la nube. Garantiza privacidad total, ya que los datos del usuario permanecen en el equipo, reduce la latencia al ofrecer respuestas casi instantáneas, minimiza costos al prescindir de tarifas por uso o límites de API, y proporciona una integración flexible con flujos de trabajo personalizados.

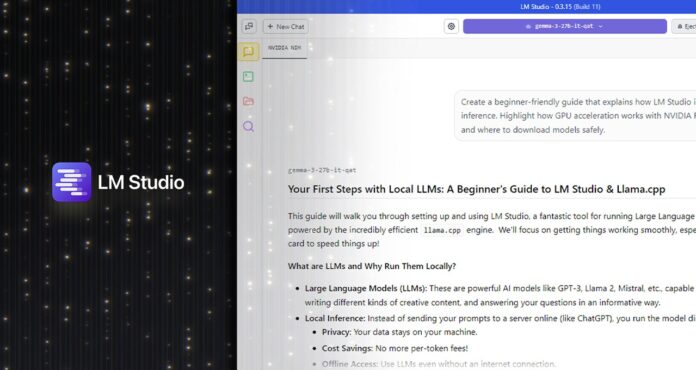

LM Studio se sostiene sobre la eficiente librería llama.cpp, permitiendo el despliegue de modelos como Llama 3, Mistral y Gemma en distintos formatos de cuantización que se adaptan a diferentes configuraciones de hardware.

La integración de CUDA 12.8 permite aprovechar innovaciones específicas para GPUs RTX, incluyendo mejoras como CUDA Graphs y Flash Attention, lo que se traduce en un aumento significativo en la eficiencia de procesamiento y el rendimiento en contextos largos, además de reducir cuellos de botella en la CPU.

Para los desarrolladores avanzados, LM Studio 0.3.15 no solo mejora el rendimiento, sino que también ofrece un editor de prompts mejorado, un modo API compatible con OpenAI, y control granular sobre el uso de herramientas externas, lo cual es esencial para aplicaciones avanzadas como la generación aumentada por recuperación (RAG).

Gracias a su diseño modular, LM Studio se ha consolidado como una herramienta indispensable para desarrolladores de software, estudiantes, investigadores y creadores de contenido, permitiendo la generación de ideas, resumen de textos, o exploración de documentos sin abandonar el entorno local.

Activar el runtime de CUDA 12.8 en LM Studio es un proceso sencillo que mejora el rendimiento al máximo, proporcionando una aceleración por hardware óptima. Esta facilidad de configuración y uso hace que el despliegue local de modelos de lenguaje se posicione como una solución práctica y escalable para el futuro de la inteligencia artificial personal.

Más información y referencias en Noticias Cloud.