Meta ha lanzado al mercado su último modelo de lenguaje, Llama 3.3 70B, a partir de hoy disponible en Amazon SageMaker JumpStart. Este innovador avance en modelos de lenguaje grande (LLM) no solo promete un rendimiento equiparable al de versiones más robustas de Llama, sino que lo hace utilizando menos recursos computacionales. Esta eficiencia se traduce en costos significativamente más bajos, convirtiéndolo en una opción especialmente atractiva para aquellas empresas que buscan soluciones efectivas sin comprometer el presupuesto.

Llama 3.3 70B ha sido meticulosamente optimizado para operar con una eficacia sobresaliente, ofreciendo resultados comparables a los del modelo Llama 3.1 405B pero con una fracción del consumo de recursos. Según informa Meta, esta optimización permite ejecutar casi cinco veces más operaciones de inferencia con el mismo costo, significando un ahorro significativo para las organizaciones que decidan adoptarlo.

La arquitectura de este modelo está fundamentada en una versión mejorada del diseño de transformadores, incorporando un mecanismo de atención renovado que reduce significativamente los costos de inferencia. El proceso de aprendizaje del modelo ha sido alimentado por un extenso conjunto de datos que abarca alrededor de 15 billones de tokens, utilizando tanto contenido web como más de 25 millones de ejemplos sintéticos creados específicamente para este fin. Esta dedicación ha dotado al modelo de habilidades sólidas para interpretar y generar respuestas en una diversidad de tareas.

Una de las características sobresalientes de Llama 3.3 70B es su refinada metodología de entrenamiento. Este proceso incluye un extenso afinamiento supervisado y un aprendizaje por refuerzo a partir de comentarios humanos (RLHF). Esto ha permitido que el modelo alinee mejor sus respuestas con las preferencias humanas sin comprometer su rendimiento. En pruebas de referencia, Llama 3.3 70B mostró una consistencia notable, quedando a menos de un 2% de diferencia en seis de diez evaluaciones estándar de inteligencia artificial y superando a modelos más grandes en tres categorías.

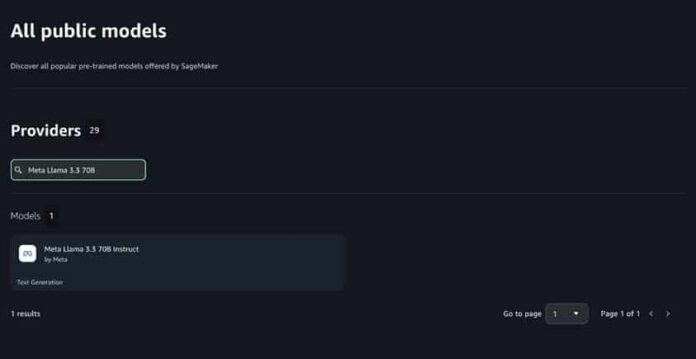

Para simplificar la implementación de este nuevo modelo, SageMaker JumpStart proporciona herramientas para evaluar, comparar y seleccionar modelos preentrenados, incluyendo los pertenecientes a la familia Llama. Los usuarios tienen la opción de desplegar Llama 3.3 70B a través de una interfaz de usuario intuitiva o mediante un enfoque programático utilizando el SDK de Python de SageMaker.

La facilidad de despliegue del modelo, ya sea a través de la interfaz intuitiva de SageMaker JumpStart o mediante el uso del SDK de Python, ofrece flexibilidad para adaptarse a las necesidades específicas de cada organización. Las capacidades avanzadas de SageMaker AI, como la carga rápida de modelos, almacenamiento en caché de contenedores, y la opción de escalar a cero, permiten manejar los despliegues de forma eficiente, maximizando las ventajas de la estructura optimizada de Llama 3.3 70B sin incurrir en gastos innecesarios.

La integración de las avanzadas características de Llama 3.3 70B con las herramientas de SageMaker AI propone una solución integral para aquellas organizaciones que buscan maximizar tanto el rendimiento como la eficiencia de los costos en sus operaciones de modelado de lenguaje.