En el marco del evento Google Cloud Next 2025, Google ha desvelado Ironwood, su más reciente avance en el ámbito de la inteligencia artificial: la séptima generación de TPUs (Tensor Processing Units). Diseñadas desde cero, estas unidades prometen impulsar la inferencia de modelos de IA a grandes escalas con una eficiencia y rendimiento sin precedentes, abriendo la puerta a lo que el gigante tecnológico ha bautizado como la “edad de la inferencia”.

Ironwood representa el mayor salto tecnológico en la narrativa de las TPUs de Google, que comenzaron su andadura en 2016. Con esta nueva generación, la compañía se enfoca en redefinir las expectativas de la infraestructura de inteligencia artificial, permitiendo modelos que no solo reaccionan, sino que piensan y actúan proactivamente.

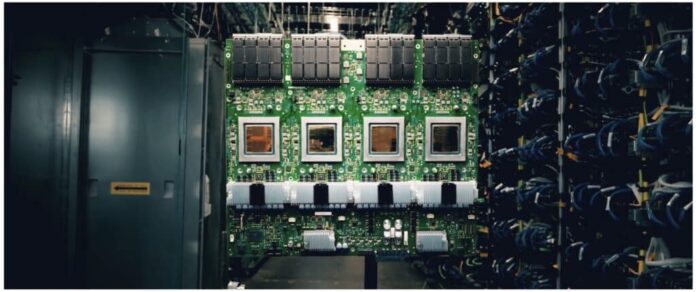

Las capacidades de Ironwood son sorprendentes, con la capacidad de escalar hasta 9.216 chips por pod, alcanzando 42,5 exaflops de potencia bruta. Esto representa más de 24 veces la capacidad del superordenador más potente del mundo, El Capitan. Cada chip individual aporta un rendimiento picos de 4.614 teraflops (FP8), con 192 GB de memoria HBM y un ancho de banda de 7,2 TB/s, rompiendo barreras previas en la computación en la nube.

Esta potencia está particularmente adaptada para manejar modelos avanzados como Gemini 2.5 o AlphaFold, así como futuras arquitecturas de LLMs (Large Language Models) y MoEs (Mixture of Experts), que exigen procesamiento paralelo extremo y acceso a memoria ultrarrápido. La nueva red Inter-Chip Interconnect (ICI) de Google, con 1,2 Tbps bidireccionales, supera en un 50% a la anterior generación con el fin de minimizar la latencia interna.

Lo que distingue a Ironwood es su enfoque en la inferencia a escala, en lugar de solo optimizar el entrenamiento. Esto se traduce en menor latencia y mejor eficiencia, crucial para servir modelos a miles de usuarios simultáneamente. Sundar Pichai, CEO de Google, lo define como un paso hacia que los modelos de IA no solo reaccionen, sino que comprendan, interpreten y actúen.

En términos de eficiencia, Ironwood también es notable, con su sistema de refrigeración líquida y un diseño optimizado que duplica el rendimiento por vatio en comparación con la generación anterior y es hasta 30 veces más eficiente que la TPU v2 de 2018. Esta mejora no solo es técnica, sino esencial en un escenario donde la eficiencia energética es clave para la escalabilidad de las infraestructuras de IA.

Google ofrece dos configuraciones de Ironwood a sus clientes en Google Cloud: Ironwood 256, ideal para startups y pequeñas empresas, e Ironwood 9.216, dirigida a líderes del sector que requieren entrenar y servir modelos en tiempo real. Ambas configuraciones están integradas dentro del ecosistema AI Hypercomputer de Google Cloud, facilitando el escalado mediante Pathways, el entorno de aprendizaje automático de Google DeepMind.

Además del respaldo hacia LLMs y modelos generativos, Ironwood incluye mejoras para las cargas de trabajo no tradicionales, mejorando el rendimiento en sectores críticos gracias a mejoras en SparseCore para grandes embeddings.

En resumen, Google, con más de una década de experiencia en ofrecer IA a escala planetaria, ha consolidado su posición de liderazgo en computación de IA con Ironwood. Este lanzamiento no es solo un avance técnico, sino la promesa de una oferta AI-as-a-Service que permitirá escalar la inteligencia artificial sin las barreras tradicionales que enfrentarían las empresas al construir su infraestructura. En un futuro inmediato, los modelos de IA no solo serán más potentes, sino que sus capacidades de pensar y razonar establecerán la diferencia competitiva en un mundo cada vez más dependiente de la nube como plataforma de innovación.