Los modelos de lenguaje de gran tamaño (LLMs, por sus siglas en inglés) han revolucionado el procesamiento del lenguaje natural, gracias a su capacidad para entender y generar textos que imitan el lenguaje humano. Estos modelos, entrenados con vastos conjuntos de datos que abarcan una variedad de temas y dominios, están siendo cada vez más ajustados y aplicados para mejorar su rendimiento en contextos específicos. Sin embargo, el poder computacional necesario para operar estos modelos sigue siendo un desafío, especialmente cuando se necesita baja latencia en aplicaciones como la traducción en tiempo real y los asistentes de voz conversacionales.

En respuesta a esta necesidad, investigadores han desarrollado Medusa, un innovador marco que acelera la inferencia de los LLMs mediante la adición de cabezas adicionales que permiten predecir múltiples tokens de manera simultánea. Durante una demostración reciente con Medusa-1, se observó una duplicación en la velocidad de inferencia sin comprometer la calidad del modelo. Este aumento varía dependiendo del tamaño del modelo y los datos utilizados, logrando, en algunos casos, un incremento de un 1.8 veces en la velocidad.

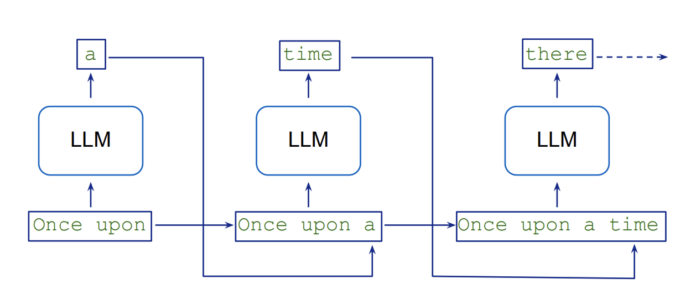

Tradicionalmente, la generación de texto en los LLMs se realiza de forma secuencial, lo que resulta en latencias inherentes porque cada nuevo token depende de los anteriores, requiriendo varias pasadas del modelo y un alto consumo de recursos. La «decodificación especulativa» ha sido una táctica para mitigar esta tardanza, utilizando un modelo más ligero para generar varias continuaciones potenciales en paralelo, que luego son verificadas por un modelo más preciso. Medusa, por su parte, elimina la necesidad de este modelo previo al integrar cabezas de decodificación que permiten la generación de candidatos simultáneamente, reduciendo así los pasos secuenciales requeridos.

Medusa presenta mejoras significativas en términos de rapidez, alcanzando hasta 2.8 veces más en la velocidad de inferencia, lo cual varía según el tamaño y la complejidad del modelo. Su compatibilidad actual incluye modelos como Llama y Mistral, aunque la implementación de Medusa podría requerir más memoria, dependiendo de la cantidad de cabezas añadidas. Entrenar estas cabezas implica tiempo y recursos, un factor a considerar durante la planificación de proyectos. Por otro lado, el marco está diseñado para un tamaño de lote de uno, haciéndolo ideal para solicitudes que demandan baja latencia.

La implementación de Medusa implica una serie de pasos, desde la preparación de los conjuntos de datos hasta su instalación en un endpoint de Amazon SageMaker AI, para lograr una inferencia más rápida en las aplicaciones de LLMs. Esto se traduce en respuestas más veloces y mejoras en la experiencia del usuario. A medida que las empresas siguen explorando el potencial de los LLMs, optimizar su rendimiento con soluciones como Medusa será esencial para enfrentar los desafíos asociados a la generación automatizada de texto.