El ajuste fino continuo de los modelos de lenguaje grande (LLM) preentrenados ha emergido como una herramienta poderosa para personalizar estos sistemas, asegurando su relevancia y precisión en diversos escenarios. Este proceso dinámico permite que los LLM se adapten a entornos en evolución, manteniendo su efectividad y evitando el deterioro del rendimiento. La capacidad de integrar retroalimentación humana y corregir errores es clave para su aplicación efectiva en situaciones del mundo real.

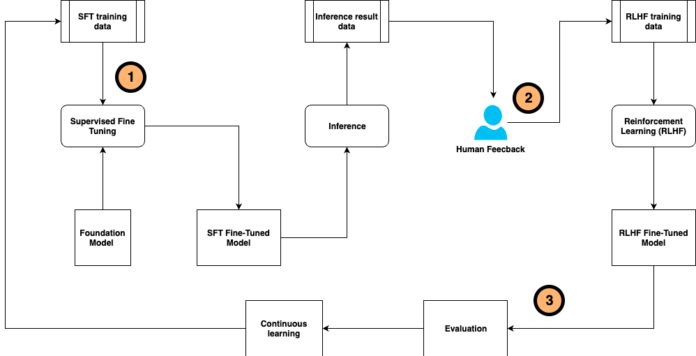

El ajuste fino, especialmente mediante el uso de técnicas supervisadas (SFT) y la afinación de instrucciones, requiere conjuntos de datos extensos, anotados meticulosamente por seres humanos. A medida que los modelos generan respuestas, el aprendizaje por refuerzo basado en retroalimentación humana (RLHF) ajusta y recompensa las salidas que se alinean mejor con las preferencias humanas. Sin embargo, este proceso, aunque efectivo, es intensivo en recursos y demanda considerables esfuerzos de expertos.

Para optimizar este enfoque, se ha desarrollado un marco de ajuste fino auto-instruido continuo. Este sistema integra la generación y anotación de datos de entrenamiento, la evaluación de modelos, y la recolección de retroalimentación, simplificando así el proceso de ajuste. Plantea un sistema de inteligencia artificial compuesto que no solo mejora la eficiencia, sino que también amplía la versatilidad y reutilización de los modelos.

El flujo de trabajo propuesto por este marco permite una personalización continua del modelo base, empleando tanto muestras de entrenamiento etiquetadas por humanos como retroalimentación posterior a la inferencia. Este proceso continuo es esencial para un entorno en constante cambio.

Este enfoque se enriquece con el diseño de sistemas de IA compuesta, los cuales superan las limitaciones de los modelos monolíticos tradicionales. Al integrar múltiples componentes, como diversos modelos y herramientas externas, se logra crear soluciones más avanzadas y eficientes.

Para apoyar la creación y optimización de estos sistemas, se ha lanzado DSPy, un marco de programación en Python de código abierto. Este recurso permite a los desarrolladores construir aplicaciones LLM mediante una programación modular y declarativa, ofreciendo una mayor flexibilidad y simplificando el desarrollo y mantenimiento de soluciones de inteligencia artificial.

En resumen, el sistema de ajuste fino continuo y auto-instruido representa un avance significativo en la precisión y rendimiento de los modelos de lenguaje, maximizando su adaptabilidad y reutilización en respuesta a la evolución constante de los datos y expectativas de los usuarios.