Los modelos de lenguaje de gran tamaño (LLMs) están revolucionando múltiples industrias al mejorar las interacciones con clientes y automatizar procesos empresariales. Sin embargo, su implementación en escenarios reales revela desafíos significativos, especialmente en términos de precisión, equidad y la conocida «alucinación», fenómeno donde los modelos generan información errónea o engañosa. Por esta razón, evaluar exhaustivamente el rendimiento y las salidas de estos modelos es crucial para mantener su confianza y seguridad.

La evaluación en el ciclo de vida de las aplicaciones de inteligencia artificial generativa es tan esencial como en el aprendizaje automático tradicional. Disponer de metodologías confiables permite tomar decisiones informadas en cuanto a la elección de modelos y prompts. No obstante, evaluar los LLMs es un proceso complejo y costoso debido a su habilidad para generar texto libre. Si bien la evaluación humana ofrece insights valiosos, su alta demanda de recursos impulsa la búsqueda de marcos automatizados, escalables y fácilmente integrables en el desarrollo, semejantes a las pruebas unitarias y de integración en software.

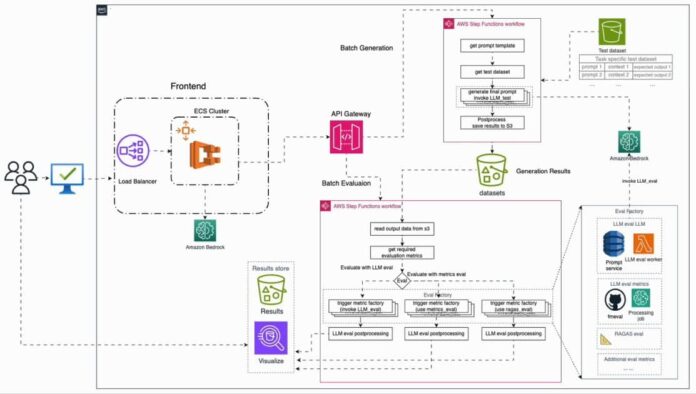

Como respuesta a estos desafíos, se ha desarrollado un marco de evaluación automatizado desplegable en AWS. Este sistema permite la integración de múltiples LLMs, utiliza métricas personalizadas y monitoriza continuamente el rendimiento de los modelos. Las «evaluaciones de LLM como juez» se valen de los nuevos modelos Amazon Nova, que destacan por su capacidad avanzada y baja latencia, ofreciendo evaluaciones escalables. La interfaz amigable del sistema facilita su uso.

Implementar procesos de evaluación para soluciones de inteligencia artificial generativa requiere establecer métricas y criterios claros, junto con un conjunto de datos representativos que incluya muestras diversas y valores de verdad generados por expertos. Este conjunto, además de abarcar casos relevantes, debe evolucionar, enriquecido con ejemplos donde el modelo haya mostrado debilidades.

Las métricas de evaluación se categorizan en tres áreas: latencia, cuya medida primordial es el tiempo de respuesta; costo, determinado por el gasto asociado a generaciones de respuesta; y rendimiento, que mide precisión y consistencia factual de las respuestas según el caso.

Tradicionalmente, los modelos se evalúan mediante un flujo de trabajo que integra evaluaciones en línea y manuales con evaluaciones automatizadas en lotes, lo cual puede conllevar complicaciones operativas. Esto demanda herramientas de comparación, servicios de gestión de prompts y servicios de inferencia a gran escala.

El nuevo sistema de evaluación automatizada de IA generativa en AWS simplifica el proceso de evaluación, mejorando la productividad durante el ciclo de desarrollo. Más allá de garantizar una evaluación eficaz de los LLMs en producción, asegura que las soluciones de inteligencia artificial generativa se mantengan actualizadas y optimizadas, cumpliendo con los estándares de precisión, equidad y relevancia.