La implementación de sistemas de Generación Aumentada por Recuperación (RAG) se ha consolidado como un pilar esencial en el avance de aplicaciones de inteligencia artificial generativa. Estos sistemas, que combinan modelos de lenguaje de gran tamaño con el conocimiento empresarial, enfrentan el desafío de crear pipelines confiables, un logro que requiere múltiples intentos y pruebas de configuraciones diversas.

La gestión de un pipeline RAG es una tarea compleja, a menudo propensa a errores debido a la administración manual. Este enfoque puede llevar a resultados inconsistentes, obstáculos en la solución de problemas y dificultades en la replicación de configuraciones exitosas. Además, la falta de automatización en este proceso se traduce en cuellos de botella, incrementando la carga operativa y complicando el mantenimiento de la calidad.

Para enfrentar estos retos, Amazon SageMaker AI emerge como una solución integral que optimiza el ciclo de vida del desarrollo de RAG, desde la experimentación hasta la automatización. Esta plataforma permite a los equipos probar eficientemente, promoviendo la colaboración y la mejora continua. SageMaker asegura que todo el pipeline esté versionado y probado, garantizando trazabilidad y mitigación de riesgos a lo largo de su desarrollo.

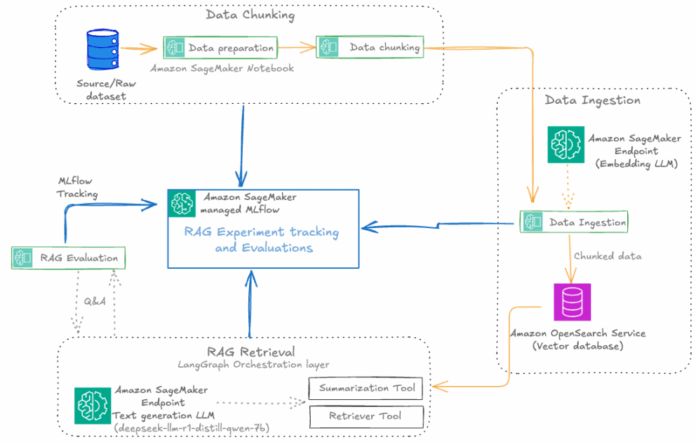

Mediante la automatización de procesos, SageMaker facilita la experimentación y los flujos de trabajo operativos, permitiendo a los equipos prototipar, desplegar y monitorear aplicaciones RAG a gran escala. La integración con MLflow ofrece un marco para rastrear experimentos, registrar configuraciones y comparar resultados, lo que respalda la reproducibilidad del proceso del pipeline.

Amazon SageMaker Pipelines orquesta flujos de trabajo RAG de extremo a extremo, mejorando la reproducibilidad y el gobierno mediante la integración continua y la entrega continua (CI/CD). Esto asegura un rendimiento consistente y de calidad cuando se trabaja con grandes conjuntos de datos en tiempo real.

Además, la solución incorpora herramientas como Amazon OpenSearch Service para la gestión de bases de datos de vectores y Amazon Bedrock, que proporciona modelos de LLM. Esta combinación permite construir, evaluar y desplegar pipelines RAG a gran escala, facilitando flujos de trabajo automatizados y reproducibles.

Con este enfoque, las organizaciones pueden realizar ajustes rápidamente, mejorando los modelos en un entorno empresarial dinámico. La simplicidad y efectividad de SageMaker, junto con su capacidad de integración con herramientas de CI/CD, posicionan a los equipos para avanzar significativamente en sus iniciativas de inteligencia artificial.