Google ha dado un golpe de efecto en la conferencia Hot Chips con el lanzamiento de Ironwood, la nueva generación de sus Tensor Processing Units (TPU), enfocada en la inferencia de modelos de lenguaje y razonamiento a gran escala. Este avance marca un cambio crucial en el desarrollo de hardware de inteligencia artificial, al enfocarse no solo en el entrenamiento, sino en la ejecución eficiente de modelos en producción.

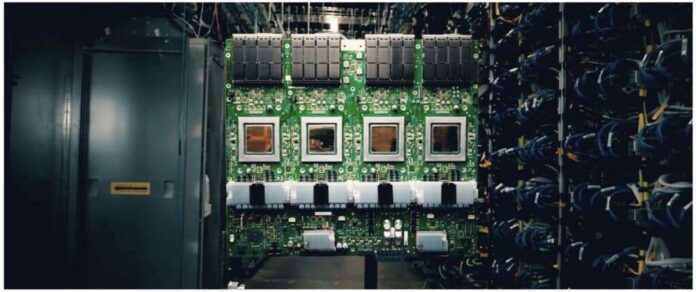

Ironwood destaca por su capacidad de escalar hasta 9.216 chips en un único nodo, lo que permite alcanzar impresionantes 42,5 exaflops de rendimiento (FP8). Esta potencia se complementa con 1,77 petabytes de memoria HBM3e, interconectada mediante Optical Circuit Switches (OCS), duplicando así la capacidad de la generación anterior, la TPUv4.

La eficiencia energética también es un pilar de Ironwood. Google afirma que ofrece el doble de rendimiento por vatio en comparación con su antecesora, Trillium, y hasta seis veces más que la TPUv4. Esto se logra mediante una arquitectura multi-chiplet, optimizaciones en la memoria y avances en refrigeración líquida, que gestionan eficazmente las cargas eléctricas en despliegues a gran escala.

La fiabilidad ha sido una prioridad en el desarrollo de Ironwood. Incorporando características como checkpointing automático y detección de corrupción de datos, se asegura una operación ininterrumpida y segura. Además, la seguridad se refuerza con un arranque seguro y soporte de confidential computing.

Un aspecto innovador de Ironwood es la utilización de inteligencia artificial no solo para ejecutar modelos, sino para diseñar el hardware. Esto se ha logrado mediante la colaboración con el equipo AlphaChip de Google, que optimizó el diseño de ALUs y el floorplanning utilizando IA.

El nuevo chip también introduce la cuarta generación de SparseCore, aceleradores dedicados a manejar embeddings y operaciones colectivas, fundamentales para modelos masivos. Además, su integración en racks con tecnología avanzada permite un manejo fluido y coordinado de las cargas de trabajo.

Ironwood estará disponible exclusivamente a través de Google Cloud, reforzando así el enfoque de Google de proporcionar infraestructura integral a escala empresarial. Esto ofrece a los usuarios de Google Cloud beneficios como inferencia en tiempo real y mayor estabilidad, clave para la implementación de inteligencia artificial generativa.

Con este lanzamiento, Google reafirma su posición de liderazgo en el hardware para IA, compitiendo directamente con gigantes como NVIDIA, pero con un enfoque específico en la inferencia masiva. Ironwood aparece como un poderoso sistema preparado para la era de modelos de billones de parámetros, prometiendo revolucionar el paisaje de la inteligencia artificial en producción.

Más información y referencias en Noticias Cloud.