Los agentes de inteligencia artificial están ocupando un lugar central en los flujos de trabajo de atención al cliente, facilitando la automatización, la toma de decisiones y la optimización en diversas industrias. No obstante, su integración en sistemas de producción plantea la necesidad de utilizar pipelines de evaluación escalables que permitan medir y mejorar su desempeño en tareas específicas. La evaluación de estos agentes es crucial para garantizar la seguridad, control y transparencia de los sistemas.

Amazon Bedrock Agents utiliza modelos de base (FMs) presentes en Amazon Bedrock, junto con APIs y datos, para desglosar solicitudes y ejecutar tareas de forma eficiente. Esta tecnología libera a los equipos para enfocarse en tareas de mayor valor, automatizando procesos complejos.

Paralelamente, Ragas, una librería de código abierto, ha sido desarrollada para probar y evaluar aplicaciones de modelos de lenguaje grande (LLM), como la generación aumentada por recuperación (RAG). Este marco cuantifica la efectividad de la implementación de RAG y se ha utilizado recientemente para evaluar la capacidad RAG de los agentes de Amazon Bedrock.

El enfoque LLM-as-a-judge emplea LLMs para evaluar la calidad de las salidas generadas por IA. Este método se utilizó para analizar las capacidades de conversión de texto a SQL y de razonamiento en cadena de los agentes.

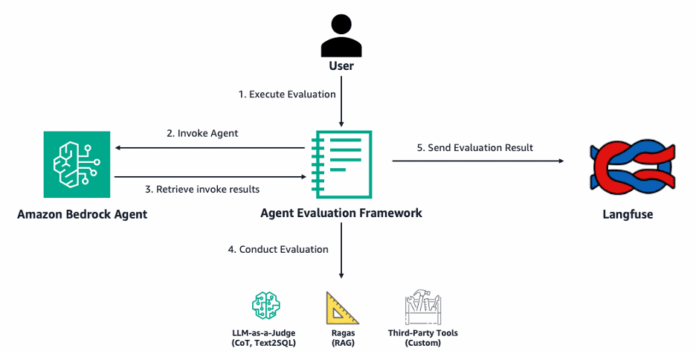

Langfuse, otra plataforma de código abierto, ofrece herramientas como trazas, evaluaciones y métricas que facilitan la depuración y mejora de aplicaciones LLM. Un nuevo marco de evaluación de agentes Bedrock, también de código abierto, permite evaluar el rendimiento en tareas de RAG y conversión de texto a SQL, integrando sus resultados en paneles visualizados en Langfuse.

Los desarrolladores enfrentan retos técnicos al evaluar estos agentes, como la realización de evaluaciones integrales y la gestión de experimentos debido a múltiples configuraciones posibles. Para simplificar este proceso, el marco de Open Source Bedrock Agent Evaluation permite especificar un ID de agente y ejecutar evaluaciones que analizan trazas, cuyo análisis se envía a Langfuse.

Particularmente, en la investigación farmacéutica, agentes diseñados para colaborar y analizar datos sobre biomarcadores resaltan la importancia de una evaluación eficaz. Estas tecnologías facilitan el descubrimiento de información crítica en investigación médica, subrayando la necesidad de herramientas efectivas que aseguren el rendimiento, confianza y seguridad de los agentes de IA en entornos sensibles.