El desafío del desarrollo de soluciones de inteligencia artificial multilingües ha encontrado un nuevo aliado en Amazon Bedrock Evaluations. A medida que las empresas intentan implementar respuestas de IA en varios idiomas, se enfrentan a dificultades significativas para evaluar la calidad de estas respuestas de manera eficiente y costo-efectiva. Las soluciones tradicionales requieren un gran esfuerzo humano y recursos financieros, lo que limita la capacidad de las organizaciones para escalar sus procesos de evaluación sin sacrificar calidad.

Amazon Bedrock introduce un enfoque innovador con su concepto de LLM-as-a-judge, que permite una evaluación consistente a través de diferentes idiomas, minimizando el tiempo y los recursos tradicionalmente necesarios para tales procesos. Esta solución ofrece resultados confiables sin necesidad de infraestructuras localizadas o personalizaciones complejas.

El sistema se basa en un enfoque dual que combina métodos automáticos y humanos para evaluar modelos de lenguaje. Las evaluaciones automáticas permiten seleccionar entre métricas predefinidas o crear métricas personalizadas, facilitando la valoración tanto de modelos internos como externos. A su vez, las evaluaciones humanas proporcionan un marco de referencia vital al comparar resultados con puntuaciones automáticas.

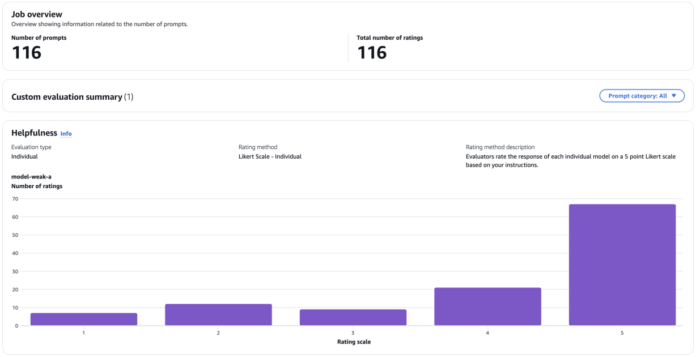

Para poner a prueba las capacidades de Amazon Bedrock Evaluations, se realizó una prueba con un conjunto de datos conversacionales en indonesio, transformando interacciones multigeneracionales en turnos individuales para una evaluación más precisa. Las evaluaciones resultantes mostraron que los modelos más robustos tuvieron una correlación significativa con evaluaciones humanas, mientras que los modelos más débiles mostraron una diferencia notable en las puntuaciones.

Además, este estudio confirmó la efectividad de utilizar prompts en inglés para evaluar resultados generados en otros idiomas, demostrando que la traducción de prompts no es esencial para una evaluación precisa. Esto abre la puerta a escalas más amplias de las evaluaciones de IA en contextos globales.

La investigación concluyó que los métodos de LLM-as-a-judge son una solución práctica para evaluaciones rápidas y económicas en implementaciones a gran escala. A pesar de la eficiencia de las evaluaciones automatizadas, la participación humana sigue siendo crucial para establecer estándares de referencia y asegurar que las evaluaciones cumplan con las expectativas de calidad de los usuarios finales.