La técnica de Generación Aumentada por Recuperación (RAG) ha emergido como una herramienta poderosa para mejorar las capacidades de los grandes modelos de lenguaje (LLMs). Al combinar el vasto conocimiento almacenado en fuentes de datos externas con el poder generativo de los LLMs, RAG permite abordar tareas complejas que requieren tanto conocimiento como creatividad. Hoy en día, las técnicas RAG se utilizan en empresas de todas las escalas, donde la inteligencia artificial generativa se emplea para resolver preguntas basadas en documentos y otros tipos de análisis.

Construir un sistema RAG simple es directo; sin embargo, desarrollar sistemas RAG de producción utilizando patrones avanzados representa un desafío considerable. Una tubería RAG de producción generalmente opera sobre un mayor volumen de datos y con una mayor complejidad, además de tener que cumplir con un estándar de calidad más alto en comparación con la construcción de una prueba de concepto. Un desafío común para los desarrolladores es la baja calidad de respuesta, un problema que puede originarse por diversas razones:

- Recuperaciones incorrectas: Falta el contexto relevante necesario para responder a la pregunta.

- Respuestas incompletas: El contexto relevante está presente solo parcialmente, resultando en respuestas que no cubren completamente la consulta.

- Alucinaciones: A pesar de la presencia del contexto relevante, el modelo no puede extraer la información adecuada para responder la pregunta.

Estos problemas requieren técnicas RAG más avanzadas en los componentes de comprensión de consultas, recuperación y generación para manejarlos eficazmente.

En este contexto surge LlamaIndex, una biblioteca de código abierto con técnicas tanto simples como avanzadas, que permite a los desarrolladores construir tuberías RAG de producción. LlamaIndex ofrece un marco flexible y modular para construir y consultar índices de documentos, integrándose con varios LLMs e implementando patrones RAG avanzados.

Por otro lado, Amazon Bedrock es un servicio gestionado que proporciona acceso a modelos fundacionales de alto rendimiento de proveedores líderes de inteligencia artificial a través de una API unificada. Ofrece una amplia gama de modelos grandes para elegir, junto con capacidades para construir y personalizar de forma segura aplicaciones de IA generativa. Las características avanzadas incluyen la personalización del modelo con ajuste fino y entrenamiento continuo utilizando sus propios datos, así como RAG para aumentar las salidas del modelo recuperando contexto de bases de conocimiento configuradas que contienen sus fuentes de datos privadas. Otras capacidades empresariales incluyen el rendimiento asegurado para inferencias de baja latencia a escala, evaluación del modelo para comparar el rendimiento y salvaguardas de IA para implementar medidas de seguridad.

El uso conjunto de LlamaIndex y Amazon Bedrock permite configurar diversas estructuras RAG avanzadas, tales como:

- Tubería RAG simple: Configuración básica en LlamaIndex con modelos de Amazon Bedrock y búsqueda vectorial top-k.

- Consulta de router: Implementación de un router automatizado para realizar búsquedas semánticas o resúmenes sobre datos.

- Consulta de sub-preguntas: Añadir una capa de descomposición de consultas complejas en múltiples consultas más simples y ejecutarlas con las herramientas relevantes.

- RAG agencial: Construcción de un agente con estado capaz de realizar las tareas anteriores, manteniendo un historial de conversación y razonamiento a lo largo del tiempo.

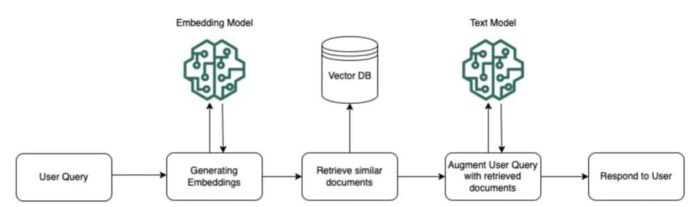

En esencia, RAG implica recuperar información relevante de fuentes de datos externas y usarla para aumentar las indicaciones dadas a un LLM. Esto permite que el LLM genere respuestas fundamentadas en conocimientos factuales y adaptadas a la consulta específica. Para flujos de trabajo RAG en Amazon Bedrock, los documentos de bases de conocimiento configuradas pasan por un preprocesamiento, donde se dividen en fragmentos, se incrustan en vectores y se indexan en una base de datos vectorial. Este proceso facilita la recuperación eficiente de información relevante en tiempo de ejecución.

Servicios como LlamaCloud y LlamaParse representan los avances más recientes en el ecosistema de LlamaIndex, con LlamaCloud ofreciendo un conjunto completo de servicios gestionados para la augmentación de contexto a nivel empresarial, y LlamaParse actuando como un motor de análisis especializado para documentos complejos. Estas herramientas permiten la gestión eficiente de grandes volúmenes de datos de producción, mejorando la calidad de las respuestas y desbloqueando capacidades sin precedentes en aplicaciones RAG.

Finalmente, la integración de Amazon Bedrock y LlamaIndex para construir una pila RAG avanzada se puede llevar a cabo siguiendo pasos precisos, desde la descarga de documentos fuente hasta la consulta final del índice con una pregunta específica. Esta configuración avanzada promete facilitar la gestión de grandes volúmenes de datos y mejorar significativamente la calidad de las respuestas generadas por los LLM en contextos complejos.

En conclusión, la combinación de capacidades de LlamaIndex y Amazon Bedrock habilita la construcción de tuberías RAG robustas y sofisticadas, maximizando el potencial de los LLMs para tareas intensivas en conocimiento.