Los avances en modelos de lenguaje de gran escala (LLMs, por sus siglas en inglés) han redefinido la interacción entre humanos y computadoras, posibilitando que los usuarios empleen lenguaje natural para interactuar con aplicaciones. Este desarrollo tecnológico ha revelado un potencial transformador en la forma en que realizamos tareas cotidianas, como programar una cita médica: un solo agente de inteligencia artificial podría revisar el calendario del usuario, acceder al sistema del proveedor, verificar el seguro y confirmar todo en una sola acción.

Sin embargo, la implementación de los agentes LLM presenta desafíos significativos, particularmente en contextos operativos complejos. Estos agentes enfrentan dificultades en la selección de herramientas, limitaciones en la gestión del contexto y la necesidad de especialización en diversas áreas como planificación y análisis. Para abordar estos problemas, se ha comenzado a implantar arquitecturas de múltiples agentes, en las cuales el sistema principal se divide en agentes más pequeños y especializados que operan de manera independiente. Esta metodología modular no solo mejora la administración del sistema, sino que también optimiza la escalabilidad de aplicaciones basadas en LLM.

Amazon Web Services (AWS) ha introducido una nueva capacidad en Amazon Bedrock que facilita la colaboración entre múltiples agentes de inteligencia artificial, permitiendo a los desarrolladores construir, implementar y gestionar equipos de agentes que trabajen de manera conjunta en tareas complejas. Este enfoque aumenta la eficacia, precisión y productividad en procesos que requieren múltiples pasos.

A diferencia de los sistemas de un solo agente, donde el agente LLM descompone tareas en secuencias menores, los sistemas de múltiples agentes gestionan flujos de trabajo distribuidos entre varios agentes. Esto requiere un mecanismo robusto de coordinación, en el cual cada agente se alinea con el objetivo común mientras contribuye individualmente. La gestión de dependencias inter-agentes y la asignación eficiente de recursos representan desafíos cruciales que demandan marcos sólidos para asegurar la coherencia y optimizar el rendimiento global del sistema.

La gestión de la memoria varía entre arquitecturas de un solo agente y de múltiples agentes. Mientras que los sistemas con un solo agente utilizan una estructura de tres niveles para gestionar memoria, los entornos multi-agente necesitan estrategias avanzadas para gestionar el contexto y sincronizar historiales de interacción.

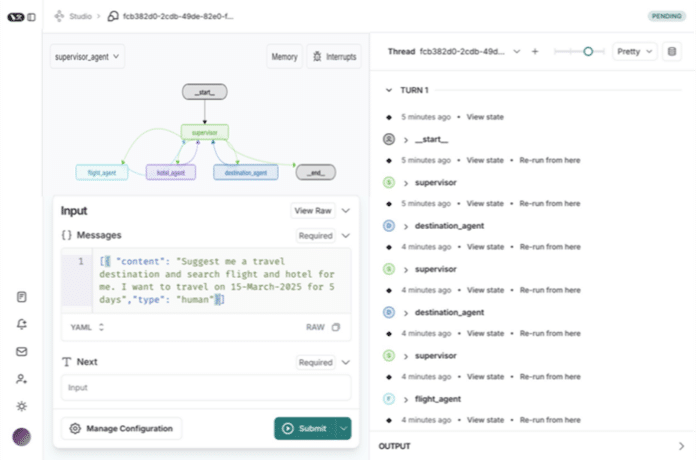

LangGraph, parte de LangChain, juega un papel vital al orquestar flujos de trabajo entre agentes con una arquitectura basada en gráficos. Esta herramienta es capaz de manejar procesos complejos y mantener el contexto a través de interacciones entre agentes. Con LangGraph Studio, los desarrolladores cuentan con un entorno de desarrollo integrado que potencia la creación de aplicaciones multi-agente mediante herramientas de visualización, monitorización y depuración en tiempo real.

Este marco utiliza máquinas de estado y gráficos dirigidos para la orquestación multi-agente, permitiendo un control detallado del flujo y el estado de las aplicaciones. Además, la arquitectura permite la incorporación de una intervención humana en procesos críticos.

Un ejemplo ilustrativo de cómo un agente supervisor coordina varios agentes especializados se da en la formación de un asistente de viaje. Este sistema gestiona tareas que van desde la recomendación de destinos hasta la búsqueda de vuelos y hoteles, estableciendo un precedente en el desarrollo de sistemas avanzados de inteligencia artificial. Esta integración de frameworks multi-agente promete no solo mejorar la experiencia del usuario, sino también la efectividad operativa de las aplicaciones.