Los modelos de lenguaje de gran tamaño (LLMs) han revolucionado la inteligencia artificial, convirtiéndose en elementos fundamentales para aplicaciones diversas, desde asistentes conversacionales hasta complejas tareas de análisis. Sin embargo, a medida que avanzan en complejidad y capacidad, evaluar su rendimiento se torna un desafío mayor. Las métricas tradicionales, como la perplejidad y los puntajes BLEU, no capturan completamente las interacciones reales, sugiriendo la necesidad de enfoques alineados con la perspectiva humana.

Recientemente, la adopción de métodos automatizados de evaluación empleando LLMs como jueces ha cobrado relevancia. Este enfoque utiliza modelos más avanzados para valorar las respuestas de otros LLMs bajo criterios de corrección, coherencia y utilidad, entre otros. La estrategia es apreciada por su capacidad de escalar, su consistencia y la eficiencia en costos, comparado con la evaluación manual.

El análisis explora dos marcos destacados: MT-Bench y Arena-Hard. MT-Bench implementa una evaluación multivuelta adaptada a interacciones de chatbot, mientras que Arena-Hard se especializa en evaluar modelos a través de duelos de respuesta en tareas avanzadas. Ambos buscan alinear la evaluación automática con la percepción humana, asegurando valoraciones más realistas.

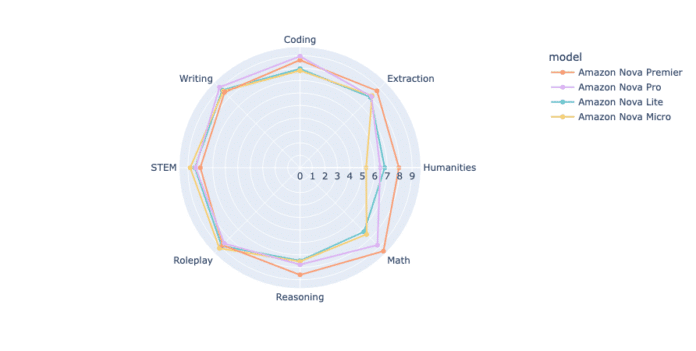

Se examinó la serie de modelos Amazon Nova, introduciendo Amazon Nova Premier en el evento AWS re:Invent de 2024. Estos modelos están ensamblados para ofrecer inteligencia de vanguardia y optimización de costos. La gama incluye desde Amazon Nova Micro, destinado a despliegues en el borde, hasta Nova Premier, enfocado en tareas más complejas.

El proceso de destilación en Amazon Bedrock facilita transferir capacidades de Nova Premier a modelos como Nova Pro o Nova Lite, haciéndolos más veloces y rentables para usuarios específicos, accesibles mediante la consola de Amazon Bedrock y APIs.

El estudio revela una jerarquía clara en rendimiento: Nova Premier lidera en puntajes medianos, seguido por Nova Pro. Nova Lite y Nova Micro destacan también, especialmente por la eficiencia de token, generando respuestas concisas. Arena-Hard-Auto, con 500 indicaciones desafiantes, ofrece una evaluación exhaustiva mediante comparaciones en pares, proporcionando un análisis más detallado de las capacidades de cada modelo.

En conclusión, los modelos Amazon Nova demuestran un rendimiento robusto en múltiples tareas mientras optimizan costos, posicionándose como una opción atractiva para empresas que priorizan la eficiencia sin sacrificar calidad. Esta investigación enfatiza la relevancia de las metodologías de evaluación para seleccionar y aplicar modelos en contextos reales.