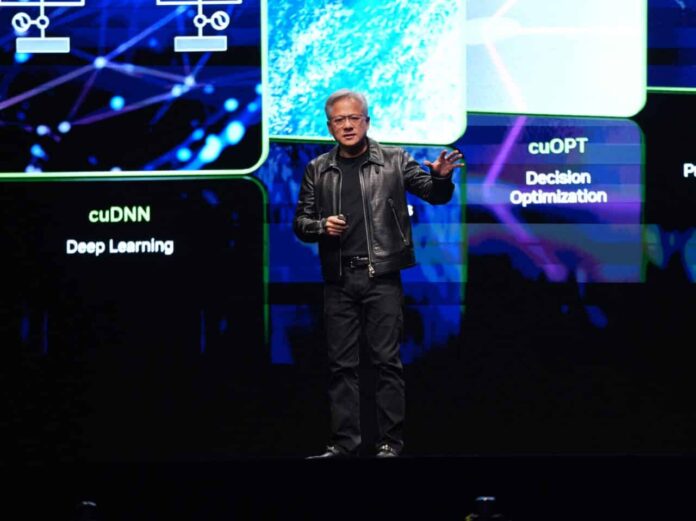

En los últimos años, la inteligencia artificial se ha convertido en el motor de un cambio paradigmático en el mundo de la tecnología. Sin embargo, no todos los avances se limitan exclusivamente al software. El debate sobre cuál es el hardware adecuado para soportar los modelos de inteligencia artificial más complejos también está tomando un lugar preponderante. Es en este contexto que Jensen Huang, CEO de NVIDIA, ha planteado una cuestión crucial para el futuro del sector: ¿pueden los ASIC desbancar a las GPU como la opción preferida para la inteligencia artificial?

Las unidades de procesamiento gráfico, o GPU, han sido la piedra angular para el entrenamiento y la ejecución de modelos de inteligencia artificial. Su capacidad de manejar operaciones paralelas masivas y compatibilidad con un amplio ecosistema de herramientas las han consolidado como la elección predilecta para investigadores y desarrolladores. Por el contrario, los circuitos integrados de aplicación específica, conocidos como ASIC, han sido diseñados con la misión de maximizar el rendimiento en tareas específicas, ofreciendo mayor eficiencia energética y menores costos operativos frente a la versatilidad de las GPU.

En una comparación directa, las GPU ofrecen una alta versatilidad y un ecosistema de herramientas vasto, como CUDA y TensorRT, que las habilita para tareas variadas tanto en inteligencia artificial como en gráficos. Sin embargo, esta adaptabilidad viene con un costo energético elevado, particularmente en operaciones prolongadas, comparadas con la eficiencia superior y el menor coste por operación que ofrecen los ASIC.

Durante una reciente intervención, Jensen Huang reconoció que mientras que actualmente las GPU de NVIDIA continúan sobresaliendo en tareas complejas de entrenamiento, el avance imparable de los ASIC pone en riesgo el liderazgo que la compañía ha construido a lo largo de los años. «Si las empresas comienzan a producir ASIC en masa y estos alcanzan niveles competitivos en entrenamiento e inferencia, nuestro liderazgo podría verse amenazado», afirmó Huang.

Compañías tecnológicas de renombre, como Google con sus Tensor Processing Units (TPU) y Amazon y Microsoft desarrollando chips propios, están explorando alternativas más eficientes para reducir costos y dependencia. Incluso OpenAI ha iniciado el diseño de ASIC propios, creando un ecosistema de desarrollo a medida que podría cambiar la dinámica del mercado.

El riesgo para NVIDIA es evidente. Si otras empresas logran replicar o incluso superar los resultados actuales utilizando chips personalizados, el modelo de negocio de NVIDIA se verá presionado, disminuyendo la demanda de GPU y potencialmente afectando su valoración en el mercado.

Pese a ello, las GPU continúan siendo la opción más extendida y flexible a día de hoy. No obstante, la eficiencia y sostenibilidad energética se están convirtiendo en factores cada vez más cruciales y los ASIC representan una amenaza real. NVIDIA enfrenta el desafío de reimaginarse frente a un futuro incierto donde su dominio podría ser disputado por soluciones más específicas diseñadas por tech-giants que buscan evitar la dependencia de un monopolio de provisiones.

Así, el futuro del hardware para inteligencia artificial está en juego, y la carrera entre GPU y ASIC apenas ha comenzado. Mientras el mundo tecnológico observa, queda por ver si NVIDIA dará el salto necesario para adaptarse a estos cambios o si los ASIC emergerán como la nueva fuerza dominante en el sector.