La inteligencia artificial generativa continúa ganando terreno en diversas áreas, y con ello, las herramientas como la Generación Aumentada por Recuperación (RAG) se vuelven imprescindibles para mejorar la precisión de sus respuestas. Esta tecnología integra datos adicionales que no estuvieron presentes en el entrenamiento original de los modelos de lenguaje, ayudando a reducir la emisión de información falsa o engañosa, también conocida como «alucinaciones» en el ámbito de la IA.

La integración de estos sistemas en decisiones críticas de la vida cotidiana subraya la importancia de detectar y mitigar dichas alucinaciones. Actualmente, las técnicas más comunes se centran en la pregunta y respuesta, pero RAG abre nuevas posibilidades al proporcionar más contexto, permitiendo abordar mejor este desafío.

Diversos métodos están siendo evaluados para desarrollar sistemas básicos de detección de alucinaciones en aplicaciones RAG. Estos métodos se analizan en función de su precisión, recuperación, y coste. Las técnicas nuevas buscan ser accesibles y fácilmente integradas en las canalizaciones de RAG, mejorando así la calidad de las respuestas generadas.

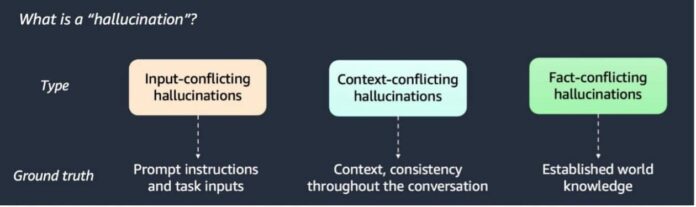

Se han clasificado tres tipos de alucinaciones, y se han propuesto técnicas como el detector basado en LLM, el de similitud semántica, y el verificador estocástico BERT. Cada uno ha mostrado eficacia variable en rapidez y rendimiento, especialmente al ser probado con datos de Wikipedia y conjuntos sintéticos.

Es fundamental contar con una cuenta en AWS que permita acceso a herramientas como Amazon SageMaker y Amazon S3. Para el funcionamiento del sistema RAG, es esencial almacenar tres componentes clave: el contexto relevante, la pregunta hecha, y la respuesta del modelo.

El enfoque LLM clasifica las respuestas del sistema considerando conflictos con el contexto. Por su parte, los métodos de similitud semántica y comparación de tokens abordan de diferentes formas las inconsistencias. El verificador BERT, aunque muy eficaz en la recuperación de información, conlleva un coste elevado.

Las comparativas sugieren que los métodos basados en LLM presentan un equilibrio adecuado entre coste y precisión. Se recomienda una combinación híbrida que incluya un detector de similitud de tokens y uno basado en LLM para enfrentar eficazmente las alucinaciones. Esta adaptabilidad es crucial para el avance de las aplicaciones de inteligencia artificial generativa.

En resumen, a medida que las aplicaciones de RAG continúan evolucionando, la detección de alucinaciones será clave para mejorar la fiabilidad y confianza en estos sistemas.