En el dinámico ámbito de la tecnología, las empresas proveedoras de modelos de inteligencia artificial generativa enfrentan desafíos sin precedentes debido a la magnitud de la escala computacional necesaria para el preentrenamiento de modelos fundamentales, conocidos como Foundation Models (FMs). Este proceso demanda la utilización de miles de aceleradores operando de manera ininterrumpida durante períodos prolongados. Para manejar tal complejidad, se implementan clústeres de entrenamiento distribuidos que se apoyan en instancias de computación avanzada, empleando marcos como PyTorch para distribuir eficazmente las cargas de trabajo entre un gran número de aceleradores, incluyendo chips como AWS Trainium e Inferentia y GPUs de NVIDIA.

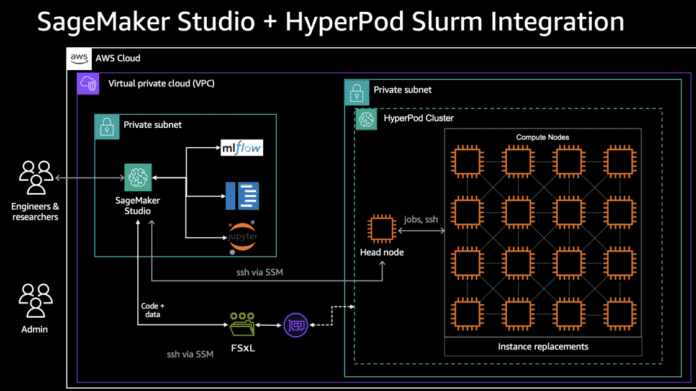

La orquestación de estos clústeres es realizada por sistemas como SLURM y Kubernetes, responsables de organizar trabajos entre nodos, gestionar recursos y procesar solicitudes de manera efectiva. En conjunto con la infraestructura de AWS, como Amazon Elastic Compute Cloud (EC2), Elastic Fabric Adapter (EFA) y sistemas de archivos distribuidos como Amazon Elastic File System (EFS) y Amazon FSx, se logran configurar ultra clústeres capaces de manejar tareas de entrenamiento e inferencia de aprendizaje automático a gran escala. No obstante, incluso los orquestadores más eficientes enfrentan retos significativos relacionados con la resiliencia, ya que los trabajos distribuidos operan sincrónicamente, y la falla de un solo nodo puede interrumpir todo el proceso.

Un elemento crítico que se debe considerar es la experiencia del desarrollador. Los flujos de trabajo tradicionales de aprendizaje automático tienden a crear silos, donde los científicos de datos trabajan en notebooks locales sin acceso al almacenamiento a escala de clúster, mientras los ingenieros gestionan trabajos de producción mediante interfaces distintas. Esta fragmentación provoca desajustes entre los ambientes de notebook y de producción y una utilización ineficaz de los recursos del clúster.

Para enfrentar estos problemas, surge Amazon SageMaker HyperPod, un entorno diseñado para el entrenamiento a gran escala de modelos fundamentales. Este sistema incorpora agentes de monitoreo que detectan fallas de hardware y permiten la reparación o sustitución automática de instancias afectadas, reanudando el entrenamiento desde el último punto guardado y minimizando la intervención manual.

Asimismo, se ha introducido Amazon SageMaker Studio, un entorno de desarrollo integrado que simplifica el ciclo de vida del aprendizaje automático. Esta plataforma ofrece una interfaz web unificada, donde los científicos de datos y desarrolladores pueden gestionar tareas de preparación de datos, modelado, entrenamiento, ajuste, evaluación, implementación y monitoreo en un solo espacio de trabajo.

La integración de SageMaker Studio con sistemas de archivos distribuidos como Amazon FSx para Lustre proporciona un almacenamiento de alto rendimiento, facilitando la conexión directa con los clústeres de SageMaker HyperPod y mejorando la productividad de los científicos de datos.

Con el avance de estas tecnologías, la industria del aprendizaje automático experimenta un impulso hacia una mayor agilidad y eficiencia, permitiendo que los científicos de datos se concentren en la innovación mientras las capacidades de computación en la nube manejan los aspectos técnicos y de resiliencia del proceso. La automatización y la mejora continua se perfilan como componentes esenciales para el éxito de cualquier operación de inteligencia artificial a gran escala, y SageMaker HyperPod junto con SageMaker Studio representan un avance prometedor en esa dirección.